Author🐯 Tigerfive

容器编排之战

Kubernetes是谷歌严格保密十几年的秘密武器—Borg的一个开源版本,是Docker分布式系统解决方案。

2014年由Google公司启动

Borg

Borg是谷歌内部使用的大规模集群管理系统,基于容器技术,目的是实现资源管理的自动化,以及跨多个数据中心的资源利用率的最大化

容器编排引擎三足鼎立:

Mesos

Docker Swarm+compose

Kubernetes

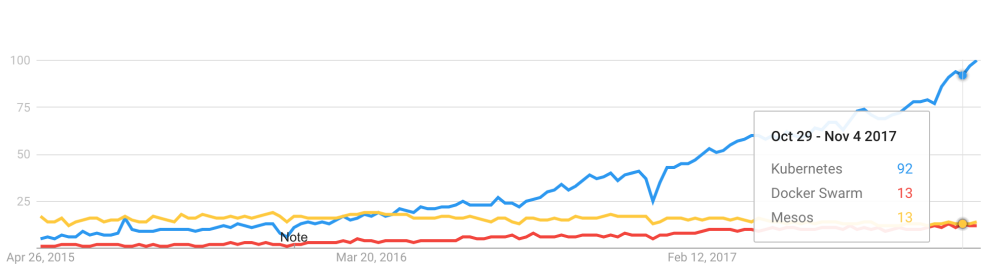

早在 2015 年 5 月,Kubernetes 在 Google 上的搜索热度就已经超过了 Mesos 和 Docker Swarm,从那儿之后更是一路飙升,将对手甩开了十几条街,容器编排引擎领域的三足鼎立时代结束。

目前,AWS、Azure、Google、阿里云、腾讯云等主流公有云提供的是基于 Kubernetes 的容器服务;Rancher、CoreOS、IBM、Mirantis、Oracle、Red Hat、VMWare 等无数厂商也在大力研发和推广基于 Kubernetes 的容器 CaaS 或 PaaS 产品。可以说,Kubernetes 是当前容器行业最炙手可热的明星。

Google 的数据中心里运行着超过 20 亿个容器,而且 Google 十几年前就开始使用容器技术。

最初,Google 开发了一个叫 Borg 的系统(现在命名为 Omega)来调度如此庞大数量的容器和工作负载。在积累了这么多年的经验后,Google 决定重写这个容器管理系统,并将其贡献到开源社区,让全世界都能受益。这个项目就是 Kubernetes。简单的讲,Kubernetes 是 Google Omega 的开源版本。

跟很多基础设施领域先有工程实践、后有方法论的发展路线不同,Kubernetes 项目的理论基础则要比工程实践走得靠前得多,这当然要归功于 Google 公司在 2015 年 4 月发布的 Borg 论文了。

Borg 系统,一直以来都被誉为 Google 公司内部最强大的"秘密武器"。虽然略显夸张,但这个说法倒不算是吹牛。

因为,相比于 Spanner、BigTable 等相对上层的项目,Borg 要承担的责任,是承载 Google 公司整个基础设施的核心依赖。在 Google 公司已经公开发表的基础设施体系论文中,Borg 项目当仁不让地位居整个基础设施技术栈的最底层。

由于这样的定位,Borg 可以说是 Google 最不可能开源的一个项目。而幸运地是,得益于 Docker 项目和容器技术的风靡,它却终于得以以另一种方式与开源社区见面,这个方式就是 Kubernetes 项目。

所以,相比于"小打小闹"的 Docker 公司、"旧瓶装新酒"的 Mesos 社区,Kubernetes 项目从一开始就比较幸运地站上了一个他人难以企及的高度:在它的成长阶段,这个项目每一个核心特性的提出,几乎都脱胎于 Borg/Omega 系统的设计与经验。更重要的是,这些特性在开源社区落地的过程中,又在整个社区的合力之下得到了极大的改进,修复了很多当年遗留在 Borg 体系中的缺陷和问题。

所以,尽管在发布之初被批评是"曲高和寡",但是在逐渐觉察到 Docker 技术栈的"稚嫩"和 Mesos 社区的"老迈"之后,这个社区很快就明白了:k8s 项目在 Borg 体系的指导下,体现出了一种独有的"先进性"与"完备性",而这些特质才是一个基础设施领域开源项目赖以生存的核心价值。

为什么是编排

一个正在运行的 Linux 容器,可以分成两部分看待:

1. 容器的静态视图

一组联合挂载在 /var/lib/docker/aufs/mnt 上的 rootfs,这一部分称为"容器镜像"(Container Image)

2. 容器的动态视图

一个由 Namespace+Cgroups 构成的隔离环境,这一部分称为"容器运行时"(Container Runtime)

作为一名开发者,其实并不关心容器运行时的差异。在整个"开发 - 测试 - 发布"的流程中,真正承载着容器信息进行传递的,是容器镜像,而不是容器运行时。

这正是容器技术圈在 Docker 项目成功后不久,就迅速走向了"容器编排"这个"上层建筑"的主要原因:作为一家云服务商或者基础设施提供商,我只要能够将用户提交的 Docker 镜像以容器的方式运行起来,就能成为这个非常热闹的容器生态图上的一个承载点,从而将整个容器技术栈上的价值,沉淀在我的这个节点上。

更重要的是,只要从这个承载点向 Docker 镜像制作者和使用者方向回溯,整条路径上的各个服务节点,比如 CI/CD、监控、安全、网络、存储等等,都有可以发挥和盈利的余地。这个逻辑,正是所有云计算提供商如此热衷于容器技术的重要原因:通过容器镜像,它们可以和潜在用户(即,开发者)直接关联起来。

从一个开发者和单一的容器镜像,到无数开发者和庞大的容器集群,容器技术实现了从"容器"到"容器云"的飞跃,标志着它真正得到了市场和生态的认可。

这样,容器就从一个开发者手里的小工具,一跃成为了云计算领域的绝对主角;而能够定义容器组织和管理规范的"容器编排"技术,则当仁不让地坐上了容器技术领域的"头把交椅"。

最具代表性的容器编排工具:

1. Docker 公司的 Compose+Swarm 组合

2. Google 与 RedHat 公司共同主导的 Kubernetes 项目

理解容器编排

Docker平台以及周边生态系统包含很多工具来管理容器的生命周期。例如,Docker Command Line Interface(CLI)满足在单个主机上管理容器的需求,但是面对部署在多个主机上的容器时就无所适从了。为了超越单个容器管理,我们必须转向编排工具。容器编排工具将生命周期管理能力扩展到部署在大量机器集群上部署的复杂的、多容器工作负载。

容器编排工具为开发人员和基础设施团队提供了一个抽象层来处理大规模的容器化部署。容器编排工具提供的特征在众多提供者之间有所不同,然而常见的公共特征包含准备、发现、资源管理、监视和部署。

由于微服务将应用程序分解为不同的微应用程序,许多开发人员会请求更多的服务器节点进行部署。为了正确地管理微服务,开发者倾向于在每个VM中部署一个微服务,这进一步降低了资源利用率。在许多情况下,这会导致CPU和内存的过度分配。

在许多部署中,微服务的高可用性需求迫使工程师添加越来越多的服务实例来进行冗余。实际上,尽管它提供了所需的高可用性,但这将导致出现一些未充分利用的服务器实例。一般而言,与单一应用程序部署相比,微服务部署需要更多的基础设施。由于基础设施成本的增加,许多组织未能看到微服务的价值。

为了解决上面提到的问题,我们需要一个工具能做到以下几点:

活动自动化。例如有效地向基础设施分配容器,这一行为对开发人员和管理员都是透明的。

为开发人员提供一个抽象层,以便他们可以在不知道使用哪个机器托管他们的应用程序的情况下,将应用程序部署到数据中心。

对部署设置规则或约束。

提供更高的敏捷性,为开发人员和管理员提供最小的管理开销和最少的人为交互。

通过最大限度地利用可用资源,有效地构建、部署和管理应用程序。

典型的容器编排工具有助于虚拟化一组机器并将它们作为单个集群管理。容器编排工具也有助于将机器上的工作负载或容器移动到消费者透明的位置。很多工具目前既支持基于DOCKER的容器,也支持非容器化二进制文件部署,例如独立的Spring Boot应用程序。这些容器编排工具的基本功能是从应用程序中抽象出实际的服务器实例。

容器编排工具的一些关键能力概括如下:

集群管理:将虚拟机和物理机器的集群管理为一台大型机器。这些机器在资源能力方面可能有些差异,但大体上都是以Linux作为操作系统的机器。这些虚拟集群可以建立在云上、本地或两者的混合。

部署:能处理有大量机器的应用程序和容器的自动部署。支持多个版本的应用程序容器,并且还支持跨越大量集群机器的滚动升级。这些工具还能够处理故障回滚。

可伸缩性:支持应用实例的自动和手动伸缩,以性能优化为主要目标。

健康:它管理集群、节点和应用程序的健康。可以从集群中移除异常的机器和应用程序实例。

基础结构抽象化:开发人员不必担心机器、容量等问题。完全是容器编排工具来决定如何调度和运行应用程序。这些工具也抽象化机器的细节、能力、使用和位置。对于应用程序所有者来说,它们相当于一个容量几乎无限的大型机器。

资源优化:这些工具以有效的方式在一组可用机器上分配容器工作负载,从而降低成本,通过从简单的到复杂的算法可有效地提高利用率。

资源分配:基于应用程序开发人员设置的资源可用性和约束来分配服务器。资源分配将基于约束、规则、端口要求、应用依赖性、健康等等。

服务可用性:确保服务在集群中正常运行。在机器故障的情况下,容器编排会自动通过在集群中的其他机器上重新启动这些服务来处理故障。

敏捷性:敏捷性工具能够快速分配工作负载到可用资源,或者在资源需求发生变化时跨机器移动工作量。此外,可以根据业务临界性、业务优先级等来设置约束重新调整资源。

隔离:一些工具提供了资源隔离。因此,即使应用程序不是容器化的,也可以实现资源隔离。

Kubernetesh介绍

首先,他是一个全新的基于容器技术的分布式架构领先方案。Kubernetes(k8s)是Google开源的容器集群管理系统(谷歌内部:Borg)。在Docker技术的基础上,为容器化的应用提供部署运行、资源调度、服务发现和动态伸缩等一系列完整功能,提高了大规模容器集群管理的便捷性。

Kubernetes是一个完备的分布式系统支撑平台,具有完备的集群管理能力,多扩多层次的安全防护和准入机制、多租户应用支撑能力、透明的服务注册和发现机制、內建智能负载均衡器、强大的故障发现和自我修复能力、服务滚动升级和在线扩容能力、可扩展的资源自动调度机制以及多粒度的资源配额管理能力。同时Kubernetes提供完善的管理工具,涵盖了包括开发、部署测试、运维监控在内的各个环节。

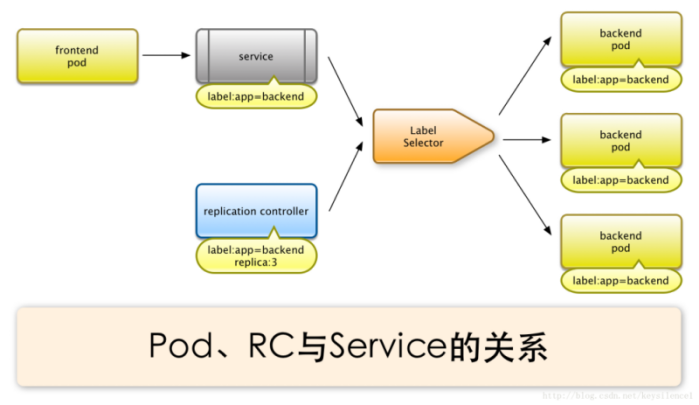

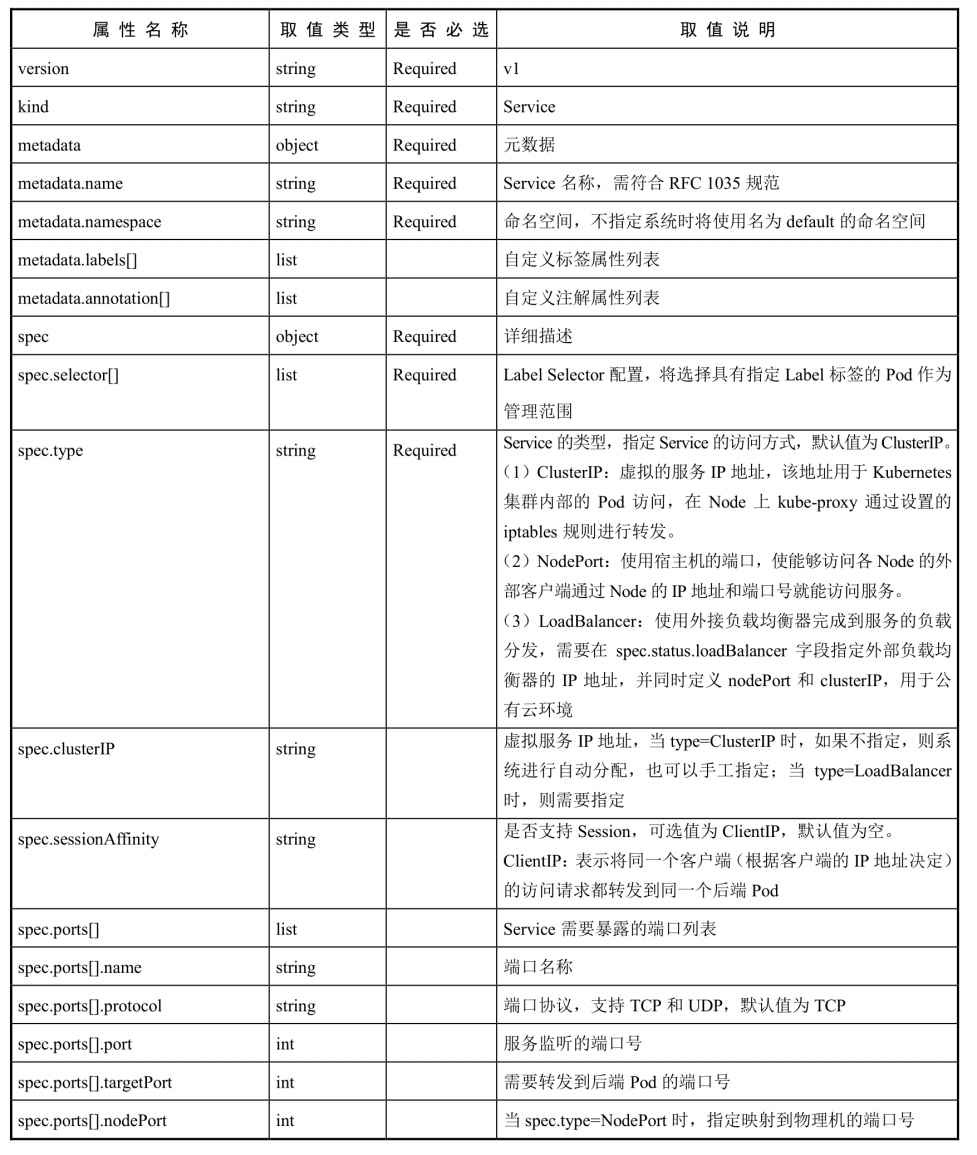

Kubernetes中,Service是分布式集群架构的核心,一个Service对象拥有如下关键特征:

拥有一个唯一指定的名字

拥有一个虚拟IP(Cluster IP、Service IP、或VIP)和端口号

能够体统某种远程服务能力

被映射到了提供这种服务能力的一组容器应用上

Service的服务进程目前都是基于Socket通信方式对外提供服务,比如Redis、Memcache、MySQL、Web Server,或者是实现了某个具体业务的一个特定的TCP Server进程,虽然一个Service通常由多个相关的服务进程来提供服务,每个服务进程都有一个独立的Endpoint(IP+Port)访问点,但Kubernetes能够让我们通过服务连接到指定的Service上。有了Kubernetes透明负载均衡和故障恢复机制,不管后端有多少服务进程,也不管某个服务进程是否会由于发生故障而重新部署到其他机器,都不会影响我们队服务的正常调用,更重要的是这个Service本身一旦创建就不会发生变化,意味着在Kubernetes集群中,我们不用为了服务的IP地址的变化问题而头疼了。

容器提供了强大的隔离功能,所有有必要把为Service提供服务的这组进程放入容器中进行隔离。为此,Kubernetes设计了Pod对象,将每个服务进程包装到相对应的Pod中,使其成为Pod中运行的一个容器。为了建立Service与Pod间的关联管理,Kubernetes给每个Pod贴上一个标签Label,比如运行MySQL的Pod贴上name=mysql标签,给运行PHP的Pod贴上name=php标签,然后给相应的Service定义标签选择器Label Selector,这样就能巧妙的解决了Service于Pod的关联问题。

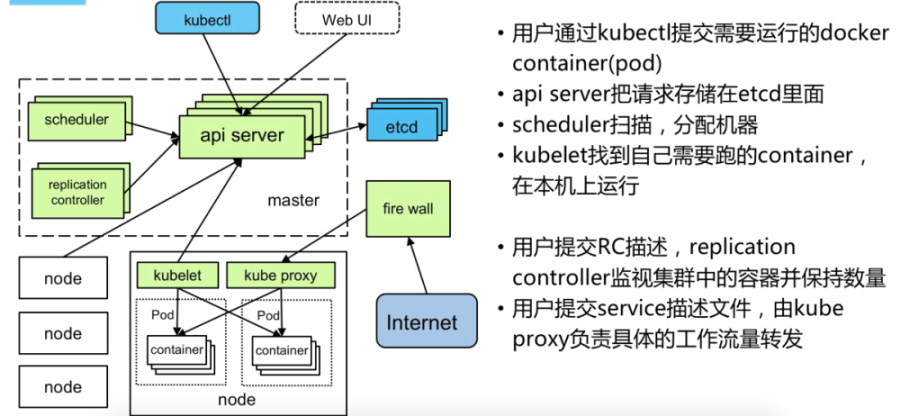

在集群管理方面,Kubernetes将集群中的机器划分为一个Master节点和一群工作节点Node,其中,在Master节点运行着集群管理相关的一组进程kube-apiserver、kube-controller-manager和kube-scheduler,这些进程实现了整个集群的资源管理、Pod调度、弹性伸缩、安全控制、系统监控和纠错等管理能力,并且都是全自动完成的。Node作为集群中的工作节点,运行真正的应用程序,在Node上Kubernetes管理的最小运行单元是Pod。Node上运行着Kubernetes的kubelet、kube-proxy服务进程,这些服务进程负责Pod的创建、启动、监控、重启、销毁以及实现软件模式的负载均衡器。

在Kubernetes集群中,它解决了传统IT系统中服务扩容和升级的两大难题。你只需为需要扩容的Service关联的Pod创建一个Replication Controller简称(RC),则该Service的扩容及后续的升级等问题将迎刃而解。在一个RC定义文件中包括以下3个关键信息。

目标Pod的定义

目标Pod需要运行的副本数量(Replicas)

要监控的目标Pod标签(Label)

在创建好RC后,Kubernetes会通过RC中定义的的Label筛选出对应Pod实例并实时监控其状态和数量,如果实例数量少于定义的副本数量,则会根据RC中定义的Pod模板来创建一个新的Pod,然后将新Pod调度到合适的Node上启动运行,知道Pod实例的数量达到预定目标,这个过程完全是自动化。

Kubernetes优势:

- 容器编排

- 轻量级

- 开源

- 弹性伸缩

- 负载均衡

Kubernetes 核心概念详解

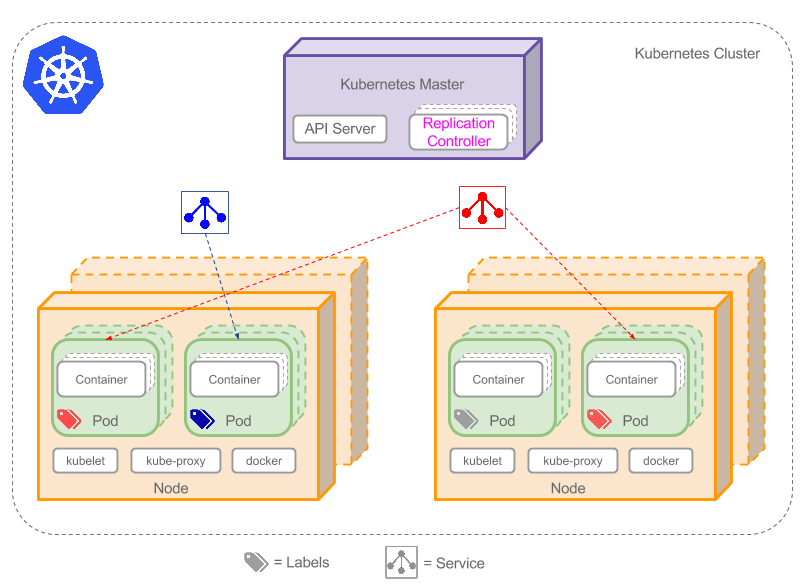

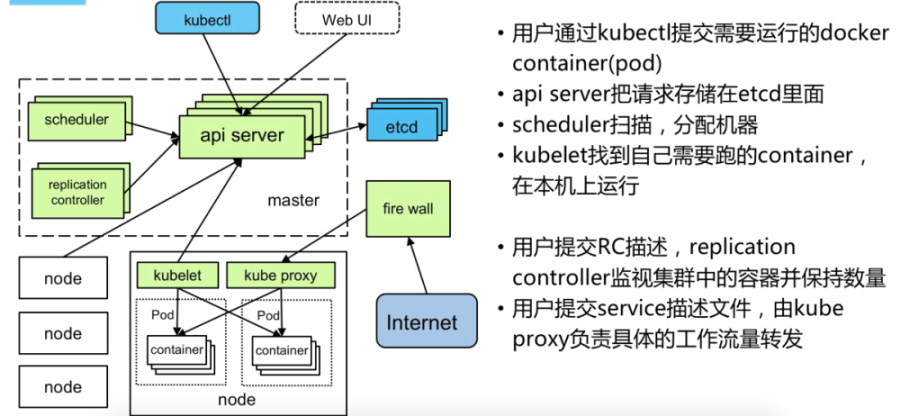

上图可以看到如下组件,使用特别的图标表示Service和Label:

• Pod

• Container(容器)

• Label( )(标签)

)(标签)

• Replication Controller(副本控制器)

• Service( )

)

• Node(节点)

• Kubernetes Master(Kubernetes控制节点)

Master

Master主要负责资源调度,控制副本,和提供统一访问集群的入口。

Node

Node由Master管理,并汇报容器状态给Master,同时根据Master要求管理容器生命周期。

Node IP

Node节点的IP地址,是Kubernetes集群中每个节点的物理网卡的IP地址,是真实存在的物理网络,所有属于这个网络的服务器之间都能通过这个网络直接通信;

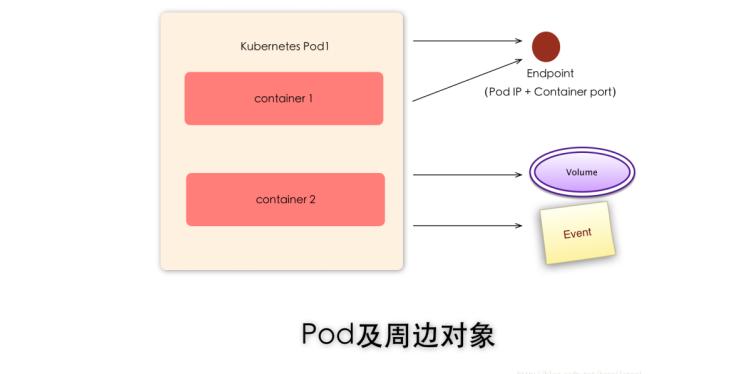

Pod

Pod直译是豆荚,可以把容器想像成豆荚里的豆子,把一个或多个关系紧密的豆子包在一起就是豆荚(一个Pod)。在k8s中我们不会直接操作容器,而是把容器包装成Pod再进行管理

运行于Node节点上, 若干相关容器的组合。Pod内包含的容器运行在同一宿主机上,使用相同的网络命名空间、IP地址和端口,能够通过localhost进行通信。Pod是k8s进行创建、调度和管理的最小单位,它提供了比容器更高层次的抽象,使得部署和管理更加灵活。一个Pod可以包含一个容器或者多个相关容器。

Pod 就是 k8s 世界里的"应用";而一个应用,可以由多个容器组成。

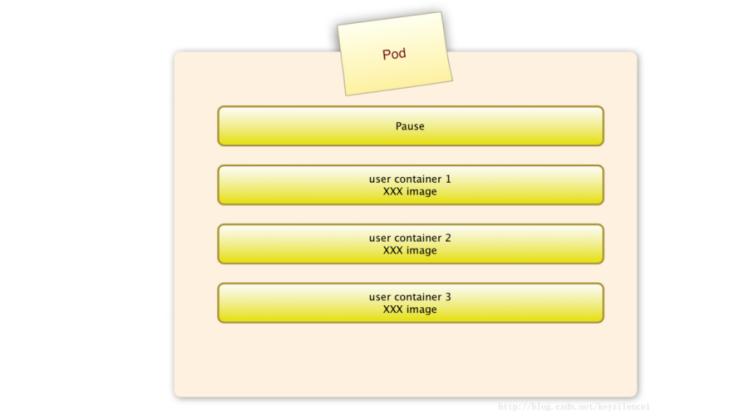

pause容器

每个Pod中都有一个pause容器,pause容器做为Pod的网络接入点,Pod中其他的容器会使用容器映射模式启动并接入到这个pause容器。

属于同一个Pod的所有容器共享网络的namespace。

一个Pod里的容器与另外主机上的Pod容器能够直接通信;

如果Pod所在的Node宕机,会将这个Node上的所有Pod重新调度到其他节点上;

Pod Volume:

Docker Volume对应Kubernetes中的Pod Volume;

资源限制:

每个Pod可以设置限额的计算机资源有CPU和Memory;

Event

是一个事件记录,记录了事件最早产生的时间、最后重复时间、重复次数、发起者、类型,以及导致此事件的原因等信息。Event通常关联到具体资源对象上,是排查故障的重要参考信息

Pod IP

Pod的IP地址,是Docker Engine根据docker0网桥的IP地址段进行分配的,通常是一个虚拟的二层网络,位于不同Node上的Pod能够彼此通信,需要通过Pod IP所在的虚拟二层网络进行通信,而真实的TCP流量则是通过Node IP所在的物理网卡流出的;

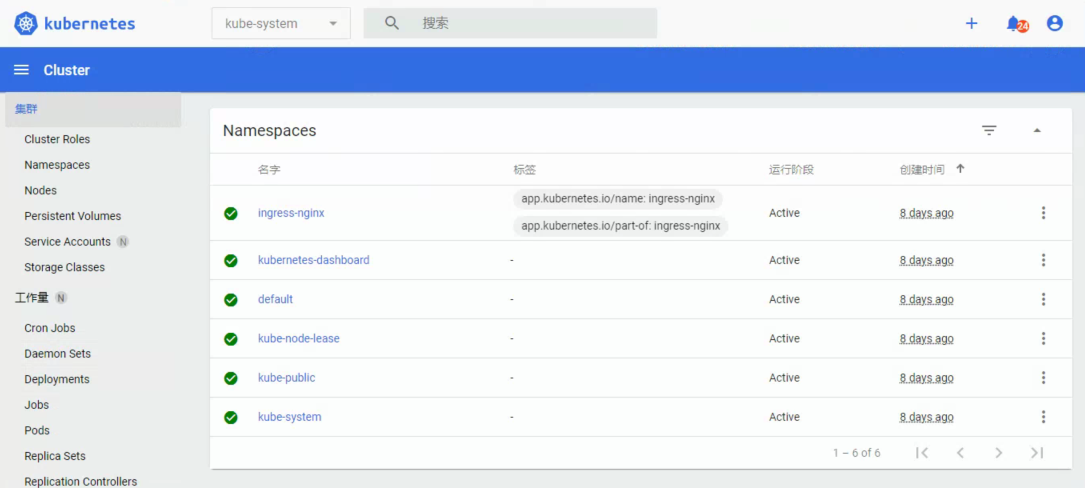

Namespace

命名空间将资源对象逻辑上分配到不同Namespace,可以是不同的项目、用户等区分管理,并设定控制策略,从而实现多租户。命名空间也称为虚拟集群。

Replica Set

确保任何给定时间指定的Pod副本数量,并提供声明式更新等功能。

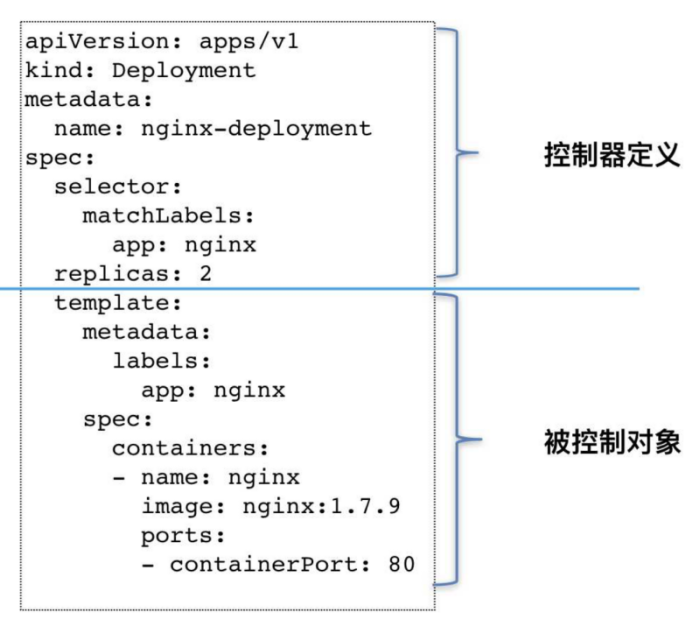

Deployment

Deployment是一个更高层次的API对象,它管理ReplicaSets和Pod,并提供声明式更新等功能。

官方建议使用Deployment管理ReplicaSets,而不是直接使用ReplicaSets,这就意味着可能永远不需要直接操作ReplicaSet对象,因此Deployment将会是使用最频繁的资源对象。

RC-Replication Controller

Replication Controller用来管理Pod的副本,保证集群中存在指定数量的Pod副本。集群中副本的数量大于指定数量,则会停止指定数量之外的多余pod数量,反之,则会启动少于指定数量个数的容器,保证数量不变。Replication Controller是实现弹性伸缩、动态扩容和滚动升级的核心。

部署和升级Pod,声明某种Pod的副本数量在任意时刻都符合某个预期值;

• Pod期待的副本数;

• 用于筛选目标Pod的Label Selector;

• 当Pod副本数量小于预期数量的时候,用于创建新Pod的Pod模板(template);

Service

Service定义了Pod的逻辑集合和访问该集合的策略,是真实服务的抽象。Service提供了一个统一的服务访问入口以及服务代理和发现机制,用户不需要了解后台Pod是如何运行。

一个service定义了访问pod的方式,就像单个固定的IP地址和与其相对应的DNS名之间的关系。

Service其实就是我们经常提起的微服务架构中的一个"微服务",通过分析、识别并建模系统中的所有服务为微服务——Kubernetes Service,最终我们的系统由多个提供不同业务能力而又彼此独立的微服务单元所组成,服务之间通过TCP/IP进行通信,从而形成了我们强大而又灵活的弹性网络,拥有了强大的分布式能力、弹性扩展能力、容错能力;

如图示,每个Pod都提供了一个独立的Endpoint(Pod IP+ContainerPort)以被客户端访问,多个Pod副本组成了一个集群来提供服务,一般的做法是部署一个负载均衡器来访问它们,为这组Pod开启一个对外的服务端口如8000,并且将这些Pod的Endpoint列表加入8000端口的转发列表中,客户端可以通过负载均衡器的对外IP地址+服务端口来访问此服务。运行在Node上的kube-proxy其实就是一个智能的软件负载均衡器,它负责把对Service的请求转发到后端的某个Pod实例上,并且在内部实现服务的负载均衡与会话保持机制。Service不是共用一个负载均衡器的IP地址,而是每个Servcie分配一个全局唯一的虚拟IP地址,这个虚拟IP被称为Cluster IP。

Cluster IP

Service的IP地址,特性:

仅仅作用于Kubernetes Servcie这个对象,并由Kubernetes管理和分配IP地址;

无法被Ping,因为没有一个"实体网络对象"来响应;

只能结合Service Port组成一个具体的通信端口;

Node IP网、Pod IP网域Cluster IP网之间的通信,采用的是Kubernetes自己设计的一种编程方式的特殊的路由规则,与IP路由有很大的不同

(Cluster IP也叫internal IP集群内部资源提供服务 区别与 external IP对外提供服务,但只能在gc2上使用因特殊原因暂时不能用)

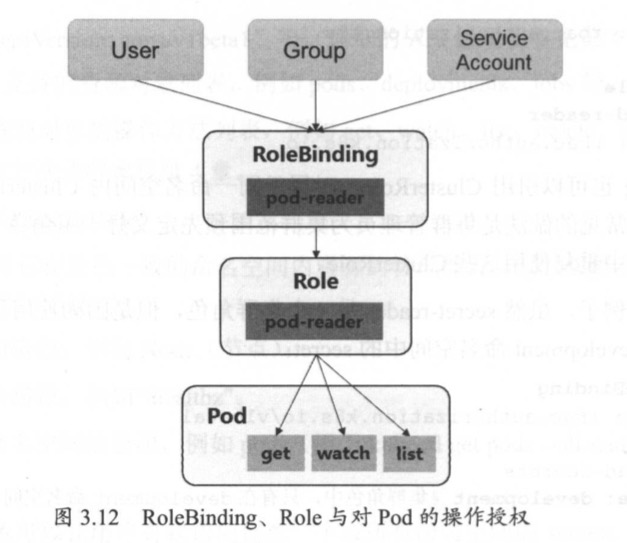

Label

Kubernetes中的任意API对象都是通过Label进行标识,Label的实质是一系列的K/V键值对。Label是Replication Controller和Service运行的基础,二者通过Label来进行关联Node上运行的Pod。

一个label是一个被附加到资源上的键/值对,譬如附加到一个Pod上,为它传递一个用户自定的并且可识别的属性.Label还可以被应用来组织和选择子网中的资源

selector是一个通过匹配labels来定义资源之间关系得表达式,例如为一个负载均衡的service指定所目标Pod

Label可以附加到各种资源对象上,一个资源对象可以定义任意数量的Label。给某个资源定义一个Label,相当于给他打一个标签,随后可以通过Label Selector(标签选择器)查询和筛选拥有某些Label的资源对象。我们可以通过给指定的资源对象捆绑一个或多个Label来实现多维度的资源分组管理功能,以便于灵活、方便的进行资源分配、调度、配置、部署等管理工作;

Node

Node是Kubernetes集群架构中运行Pod的服务节点(亦叫agent或minion)。Node是Kubernetes集群操作的单元,用来承载被分配Pod的运行,是Pod运行的宿主机。

Endpoint(IP+Port)

标识服务进程的访问点;

注:Node、Pod、Replication Controller和Service等都可以看作是一种"资源对象",几乎所有的资源对象都可以通过Kubernetes提供的kubectl工具执行增、删、改、查等操作并将其保存在etcd中持久化存储。

Volume

数据卷,挂载宿主机文件、目录或者外部存储到Pod中,为应用服务提供存储,也可以Pod中容器之间共享数据。

StatefulSet

StatefuleSet主要用来部署有状态应用,能够保证 Pod 的每个副本在整个生命周期中名称是不变的。而其他 Controller 不提供这个功能,当某个 Pod 发生故障需要删除并重新启动时,Pod 的名称会发生变化。同时 StatefuleSet 会保证副本按照固定的顺序启动、更新或者删除。

StatefulSet适合持久性的应用程序,有唯一的网络标识符(IP),持久存储,有序的部署、扩展、删除和滚动更新。

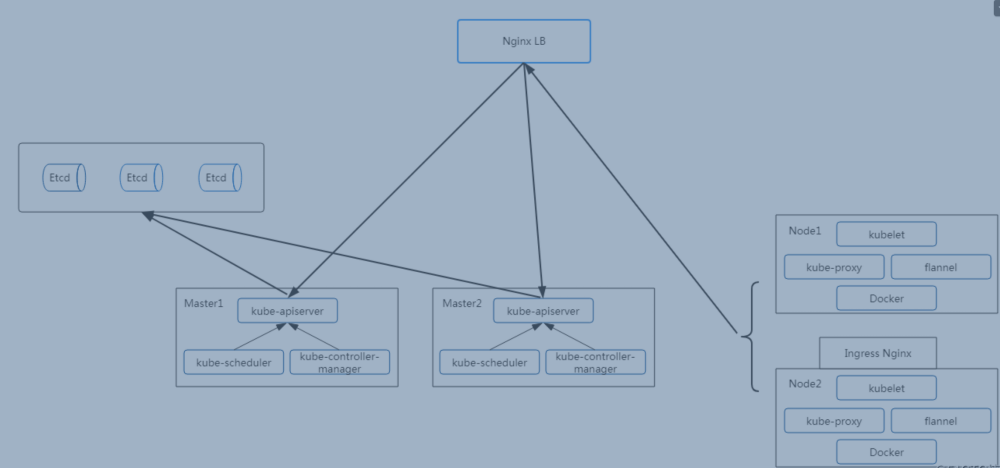

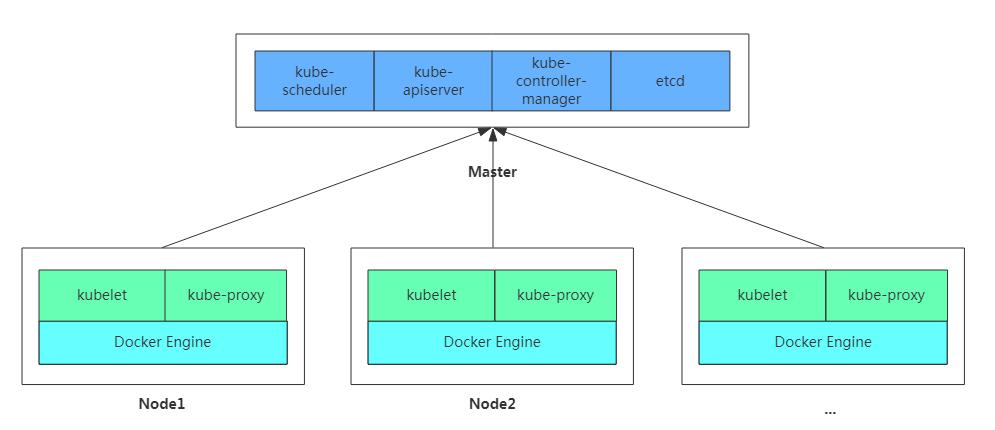

Kubernetes架构与组件

主从分布式架构,Master/Node

- 服务分组,小集群,多集群

- 服务分组,大集群,单集群

组件:

Kubernetes Master:

集群控制节点,负责整个集群的管理和控制,基本上Kubernetes所有的控制命令都是发给它,它来负责具体的执行过程,我们后面所有执行的命令基本都是在Master节点上运行的;

包含如下组件:

1.Kubernetes API Server

作为Kubernetes系统的入口,其封装了核心对象的增删改查操作,以RESTful API接口方式提供给外部客户和内部组件调用。维护的REST对象持久化到Etcd中存储。

2.Kubernetes Scheduler

为新建立的Pod进行节点(node)选择(即分配机器),负责集群的资源调度。组件抽离,可以方便替换成其他调度器。

3.Kubernetes Controller

负责执行各种控制器,目前已经提供了很多控制器来保证Kubernetes的正常运行。

- Replication Controller

管理维护Replication Controller,关联Replication Controller和Pod,保证Replication Controller定义的副本数量与实际运行Pod数量一致。 - Deployment Controller

管理维护Deployment,关联Deployment和Replication Controller,保证运行指定数量的Pod。当Deployment更新时,控制实现Replication Controller和 Pod的更新。 - Node Controller

管理维护Node,定期检查Node的健康状态,标识出(失效|未失效)的Node节点。 - Namespace Controller

管理维护Namespace,定期清理无效的Namespace,包括Namesapce下的API对象,比如Pod、Service等。 - Service Controller

管理维护Service,提供负载以及服务代理。 - EndPoints Controller

管理维护Endpoints,关联Service和Pod,创建Endpoints为Service的后端,当Pod发生变化时,实时更新Endpoints。 - Service Account Controller

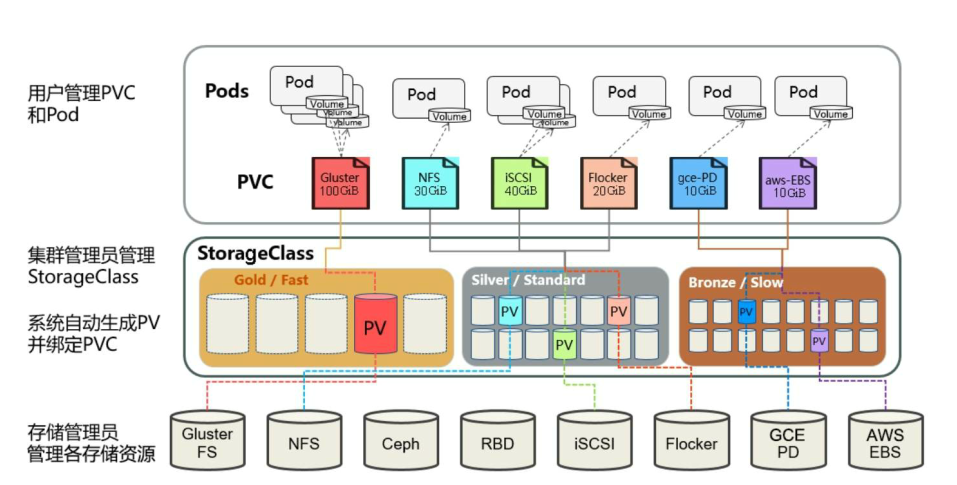

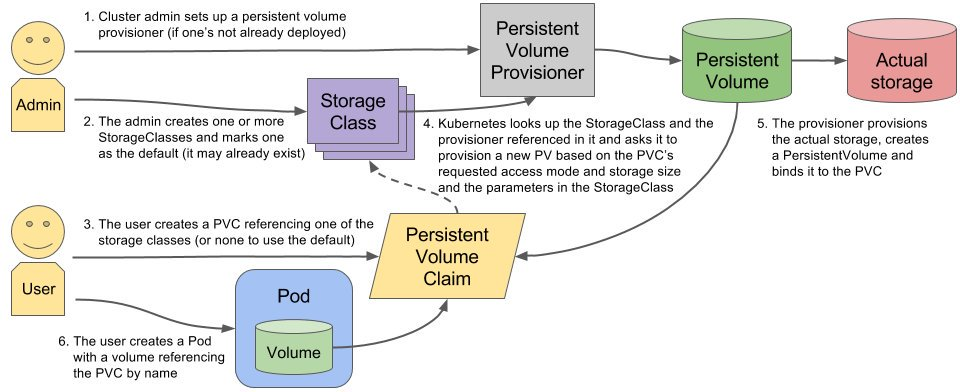

管理维护Service Account,为每个Namespace创建默认的Service Account,同时为Service Account创建Service Account Secret。 - Persistent Volume Controller

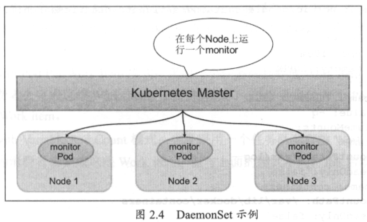

管理维护Persistent Volume和Persistent Volume Claim,为新的Persistent Volume Claim分配Persistent Volume进行绑定,为释放的Persistent Volume执行清理回收。 - Daemon Set Controller

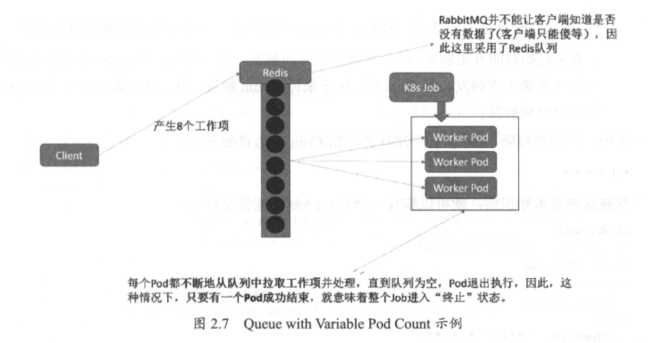

管理维护Daemon Set,负责创建Daemon Pod,保证指定的Node上正常的运行Daemon Pod。 - Job Controller

管理维护Job,为Jod创建一次性任务Pod,保证完成Job指定完成的任务数目 - Pod Autoscaler Controller

实现Pod的自动伸缩,定时获取监控数据,进行策略匹配,当满足条件时执行Pod的伸缩动作。

Kubernetes Node:

除了Master,Kubernetes集群中的其他机器被称为Node节点,Node节点才是Kubernetes集群中的工作负载节点,每个Node都会被Master分配一些工作负载(Docker容器),当某个Node宕机,其上的工作负载会被Master自动转移到其他节点上去;

包含如下组件:

1.Kubelet

负责管控容器,Kubelet会从Kubernetes API Server接收Pod的创建请求,启动和停止容器,监控容器运行状态并汇报给Kubernetes API Server。

2.Kubernetes Proxy

负责为Pod创建代理服务,Kubernetes Proxy会从Kubernetes API Server获取所有的Service信息,并根据Service的信息创建代理服务,实现Service到Pod的请求路由和转发,从而实现Kubernetes层级的虚拟转发网络。

3.Docker Engine(docker),Docker引擎,负责本机的容器创建和管理工作;

数据库

etcd数据库,可以部署到master上,也可以独立部署

分布式键值存储系统。用于保存集群状态数据,比如Pod、Service等对象信息。

Kubernetes部署

二进制方式部署

部署kubernetes 集群-二进制方式(一)

部署方式:

方式1. minikube

Minikube是一个工具,可以在本地快速运行一个单点的Kubernetes,尝试Kubernetes或日常开发的用户使用。不能用于生产环境。

官方地址:https://kubernetes.io/docs/setup/minikube/

方式2. kubeadm

Kubeadm也是一个工具,提供kubeadm init和kubeadm join,用于快速部署Kubernetes集群。

官方地址:https://kubernetes.io/docs/reference/setup-tools/kubeadm/kubeadm/

方式3. 直接使用epel-release yum源,缺点就是版本较低

方式4. 二进制包

从官方下载发行版的二进制包,手动部署每个组件,组成Kubernetes集群。

官方也提供了一个互动测试环境供大家测试:https://kubernetes.io/zh/docs/tutorials/kubernetes-basics/cluster-interactive/

https://kubernetes.io/docs/tutorials/kubernetes-basics/

目标任务:

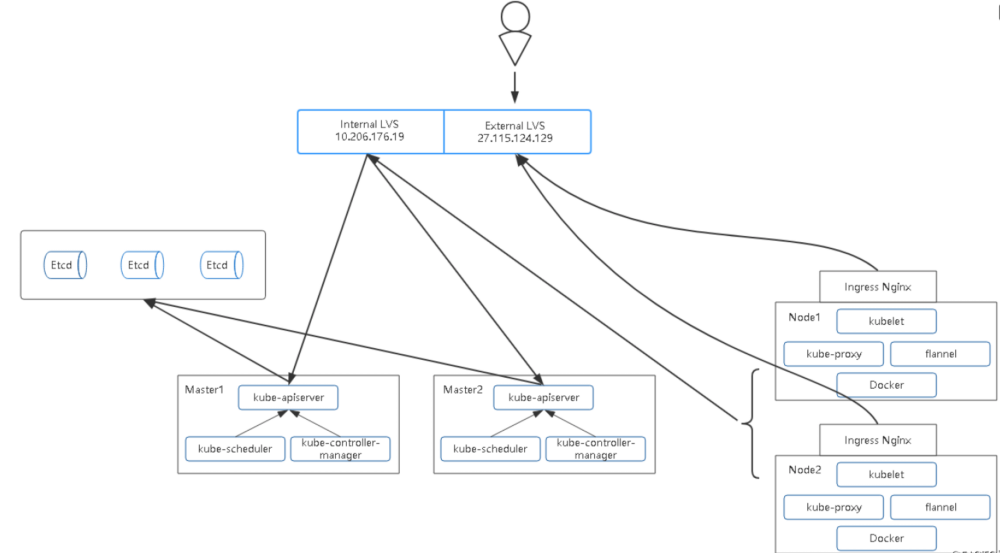

1 Kubernetes集群部署架构规划

2 部署Etcd集群

3 在Node节点安装Docker

4 部署Flannel网络

5 在Master节点部署组件

6 在Node节点部署组件

7 查看集群状态

8 运行一个测试示例

9 部署Dashboard(Web UI)

固定IP、改名字、相互解析、关闭防火墙、先做个快照、时间同步

1、Kubernetes集群部署架构规划

操作系统:

CentOS7.6_x64

软件版本:

Docker 18.09.0-ce

Kubernetes 1.11

服务器角色、IP、组件:

k8s-master1

10.206.240.188 kube-apiserver,kube-controller-manager,kube-scheduler,etcd

k8s-master2

10.206.240.189 kube-apiserver,kube-controller-manager,kube-scheduler,etcd

k8s-node1

10.206.240.111 kubelet,kube-proxy,docker,flannel,etcd

k8s-node2

10.206.240.112 kubelet,kube-proxy,docker,flannel

Master负载均衡

10.206.176.19 LVS

镜像仓库

10.206.240.188 Harbor

拓扑图

负载均衡器:

云环境:

可以采用slb

非云环境:

主流的软件负载均衡器,例如LVS、HAProxy、Nginx

这里采用Nginx作为apiserver负载均衡器,架构图如下:

2. 安装nginx使用stream模块作4层反向代理配置如下:

user nginx;

worker_processes 4;

error_log /var/log/nginx/error.log warn;

pid /var/run/nginx.pid;

events {

worker_connections 1024;

}

stream {

log_format main '$remote_addr $upstream_addr - [$time_local] $status $upstream_bytes_sent';

access_log /var/log/nginx/k8s-access.log main;

upstream k8s-apiserver {

server 10.206.240.188:6443;

server 10.206.240.189:6443;

}

server {

listen 6443;

proxy_pass k8s-apiserver;

}

}

3. 部署Etcd集群

使用cfssl来生成自签证书,任何机器都行,证书这块儿知道怎么生成、怎么用即可,暂且不用过多研究。

下载cfssl工具:

# wget https://pkg.cfssl.org/R1.2/cfssl_linux-amd64

# wget https://pkg.cfssl.org/R1.2/cfssljson_linux-amd64

# wget https://pkg.cfssl.org/R1.2/cfssl-certinfo_linux-amd64

# chmod +x cfssl_linux-amd64 cfssljson_linux-amd64 cfssl-certinfo_linux-amd64

# mv cfssl_linux-amd64 /usr/local/bin/cfssl

# mv cfssljson_linux-amd64 /usr/local/bin/cfssljson

# mv cfssl-certinfo_linux-amd64 /usr/bin/cfssl-certinfo

生成Etcd证书:

创建以下三个文件:

# cat ca-config.json

{

"signing": {

"default": {

"expiry": "87600h"

},

"profiles": {

"www": {

"expiry": "87600h",

"usages": [

"signing",

"key encipherment",

"server auth",

"client auth"

]

}

}

}

}

# cat ca-csr.json

{

"CN": "etcd CA",

"key": {

"algo": "rsa",

"size": 2048

},

"names": [

{

"C": "CN",

"L": "Beijing",

"ST": "Beijing"

}

]

}

# cat server-csr.json

{

"CN": "etcd",

"hosts": [

"10.206.240.188",

"10.206.240.189",

"10.206.240.111"

],

"key": {

"algo": "rsa",

"size": 2048

},

"names": [

{

"C": "CN",

"L": "BeiJing",

"ST": "BeiJing"

}

]

}

生成证书:

# cfssl gencert -initca ca-csr.json | cfssljson -bare ca -

# cfssl gencert -ca=ca.pem -ca-key=ca-key.pem -config=ca-config.json -profile=www server-csr.json | cfssljson -bare server

# ls *pem

ca-key.pem ca.pem server-key.pem server.pem

安装Etcd:

二进制包下载地址:

https://github.com/coreos/etcd/releases/tag/v3.2.12

https://github.com/etcd-io/etcd/releases/download/v3.2.12/etcd-v3.2.12-linux-amd64.tar.gz

以下部署步骤在规划的三个etcd节点操作一样,唯一不同的是etcd配置文件中的服务器IP要写当前的:

解压二进制包:

# mkdir /opt/etcd/{bin,cfg,ssl} -p

# tar zxvf etcd-v3.2.12-linux-amd64.tar.gz

# mv etcd-v3.2.12-linux-amd64/{etcd,etcdctl} /opt/etcd/bin/

创建etcd配置文件:

# cat /opt/etcd/cfg/etcd

#[Member]

ETCD_NAME="etcd01"

ETCD_DATA_DIR="/var/lib/etcd/default.etcd"

ETCD_LISTEN_PEER_URLS="https://10.206.240.189:2380"

ETCD_LISTEN_CLIENT_URLS="https://10.206.240.189:2379"

#[Clustering]

ETCD_INITIAL_ADVERTISE_PEER_URLS="https://10.206.240.189:2380"

ETCD_ADVERTISE_CLIENT_URLS="https://10.206.240.189:2379"

ETCD_INITIAL_CLUSTER="etcd01=https://10.206.240.189:2380,etcd02=https://10.206.240.188:2380,etcd03=https://10.206.240.111:2380"

ETCD_INITIAL_CLUSTER_TOKEN="etcd-cluster"

ETCD_INITIAL_CLUSTER_STATE="new"

* ETCD_NAME 节点名称 修改

* ETCD_DATA_DIR 数据目录

* ETCD_LISTEN_PEER_URLS 集群通信监听地址 修改

* ETCD_LISTEN_CLIENT_URLS 客户端访问监听地址 修改

* ETCD_INITIAL_ADVERTISE_PEER_URLS 集群通告地址 修改

* ETCD_ADVERTISE_CLIENT_URLS 客户端通告地址 修改

* ETCD_INITIAL_CLUSTER 集群节点地址 修改

* ETCD_INITIAL_CLUSTER_TOKEN 集群Token

* ETCD_INITIAL_CLUSTER_STATE 加入集群的当前状态,new是新集群,existing表示加入已有集群

systemd管理etcd:

# cat /usr/lib/systemd/system/etcd.service

[Unit]

Description=Etcd Server

After=network.target

After=network-online.target

Wants=network-online.target

[Service]

Type=notify

EnvironmentFile=/opt/etcd/cfg/etcd

ExecStart=/opt/etcd/bin/etcd \

--name=${ETCD_NAME} \

--data-dir=${ETCD_DATA_DIR} \

--listen-peer-urls=${ETCD_LISTEN_PEER_URLS} \

--listen-client-urls=${ETCD_LISTEN_CLIENT_URLS},http://127.0.0.1:2379 \

--advertise-client-urls=${ETCD_ADVERTISE_CLIENT_URLS} \

--initial-advertise-peer-urls=${ETCD_INITIAL_ADVERTISE_PEER_URLS} \

--initial-cluster=${ETCD_INITIAL_CLUSTER} \

--initial-cluster-token=${ETCD_INITIAL_CLUSTER_TOKEN} \

--initial-cluster-state=new \

--cert-file=/opt/etcd/ssl/server.pem \

--key-file=/opt/etcd/ssl/server-key.pem \

--peer-cert-file=/opt/etcd/ssl/server.pem \

--peer-key-file=/opt/etcd/ssl/server-key.pem \

--trusted-ca-file=/opt/etcd/ssl/ca.pem \

--peer-trusted-ca-file=/opt/etcd/ssl/ca.pem

Restart=on-failure

LimitNOFILE=65536

[Install]

WantedBy=multi-user.target

把刚才生成的证书拷贝到配置文件中的位置:

# cp ca*pem server*pem /opt/etcd/ssl

启动并设置开启启动:

# systemctl start etcd

# systemctl enable etcd

都部署完成后,检查etcd集群状态:

# /opt/etcd/bin/etcdctl \

--ca-file=/opt/etcd/ssl/ca.pem --cert-file=/opt/etcd/ssl/server.pem --key-file=/opt/etcd/ssl/server-key.pem \

--endpoints="https://10.206.240.189:2379,https://10.206.240.188:2379,https://10.206.240.111:2379" \

cluster-health

member 18218cfabd4e0dea is healthy: got healthy result from https://10.206.240.111:2379

member 541c1c40994c939b is healthy: got healthy result from https://10.206.240.189:2379

member a342ea2798d20705 is healthy: got healthy result from https://10.206.240.188:2379

cluster is healthy

如果输出上面信息,就说明集群部署成功。

如果有问题第一步先看日志:/var/log/messages 或 journalctl -xeu etcd

报错:

Jan 15 12:06:55 k8s-master1 etcd: request cluster ID mismatch (got 99f4702593c94f98 want cdf818194e3a8c32)

解决:因为集群搭建过程,单独启动过单一etcd,做为测试验证,集群内第一次启动其他etcd服务时候,是通过发现服务引导的,所以需要删除旧的成员信息,所有节点作以下操作

[root@k8s-master1 default.etcd]# pwd

/var/lib/etcd/default.etcd

[root@k8s-master1 default.etcd]# rm -rf member/

在Node节点安装Docker

# yum install -y yum-utils device-mapper-persistent-data lvm2

# yum-config-manager \

--add-repo \

https://download.docker.com/linux/centos/docker-ce.repo

# yum install docker-ce -y

# curl -sSL https://get.daocloud.io/daotools/set_mirror.sh | sh -s http://bc437cce.m.daocloud.io

# systemctl start docker

# systemctl enable docker

---

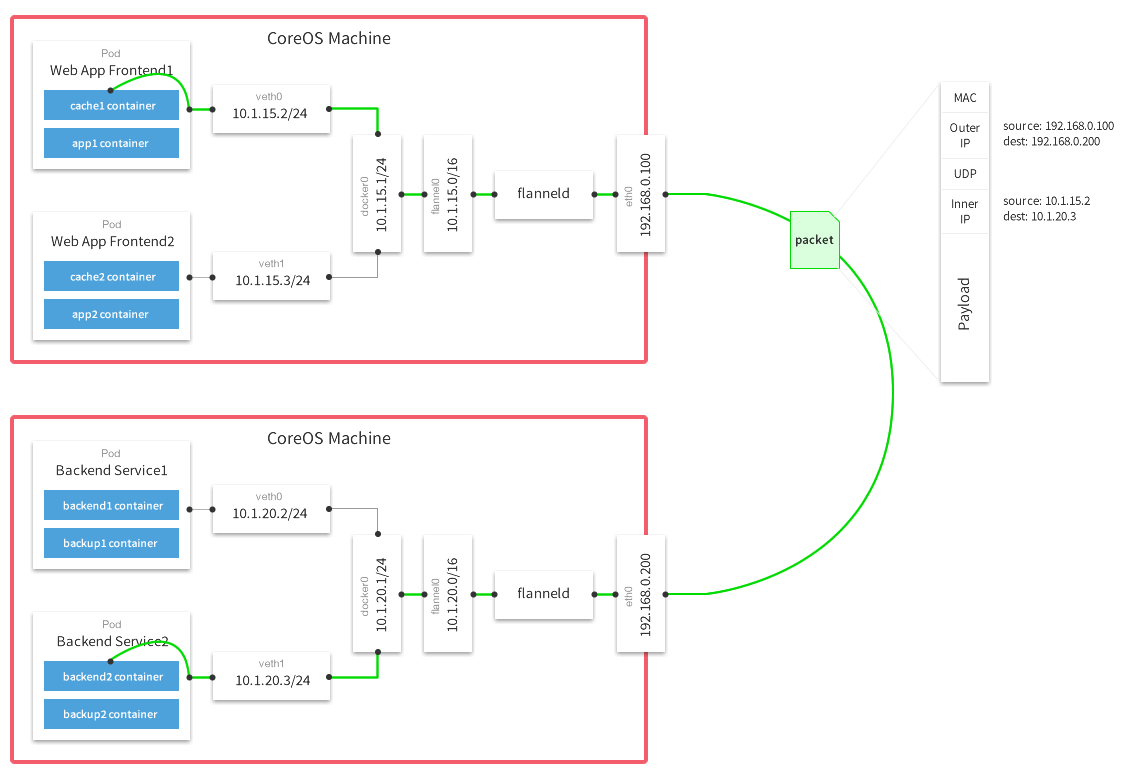

部署Flannel网络

工作原理:

Falnnel要用etcd存储自身一个子网信息,所以要保证能成功连接Etcd,写入预定义子网段:

# /opt/etcd/bin/etcdctl \

--ca-file=ca.pem --cert-file=server.pem --key-file=server-key.pem \

--endpoints="https://10.206.240.189:2379,https://10.206.240.188:2379,https://10.206.240.111:2379" \

set /coreos.com/network/config '{ "Network": "172.17.0.0/16", "Backend": {"Type": "vxlan"}}'

先要切换到etc认证目录,即/opt/etcd/ssl/

以下部署步骤在规划的每个node节点都操作。

下载二进制包:

# wget https://github.com/coreos/flannel/releases/download/v0.10.0/flannel-v0.10.0-linux-amd64.tar.gz

# tar zxvf flannel-v0.10.0-linux-amd64.tar.gz

# mkdir -pv /opt/kubernetes/bin

# mv flanneld mk-docker-opts.sh /opt/kubernetes/bin

配置Flannel:

# mkdir -pv /opt/kubernetes/cfg/

# cat /opt/kubernetes/cfg/flanneld

FLANNEL_OPTIONS="--etcd-endpoints=https://10.206.240.189:2379,https://10.206.240.188:2379,https://10.206.240.111:2379 -etcd-cafile=/opt/etcd/ssl/ca.pem -etcd-certfile=/opt/etcd/ssl/server.pem -etcd-keyfile=/opt/etcd/ssl/server-key.pem"

systemd管理Flannel:

# cat /usr/lib/systemd/system/flanneld.service

[Unit]

Description=Flanneld overlay address etcd agent

After=network-online.target network.target

Before=docker.service

[Service]

Type=notify

EnvironmentFile=/opt/kubernetes/cfg/flanneld

ExecStart=/opt/kubernetes/bin/flanneld --ip-masq $FLANNEL_OPTIONS

ExecStartPost=/opt/kubernetes/bin/mk-docker-opts.sh -k DOCKER_NETWORK_OPTIONS -d /run/flannel/subnet.env

Restart=on-failure

[Install]

WantedBy=multi-user.target

配置Docker启动指定子网段:

# cat /usr/lib/systemd/system/docker.service

[Unit]

Description=Docker Application Container Engine

Documentation=https://docs.docker.com

After=network-online.target firewalld.service

Wants=network-online.target

[Service]

Type=notify

EnvironmentFile=/run/flannel/subnet.env

ExecStart=/usr/bin/dockerd $DOCKER_NETWORK_OPTIONS

ExecReload=/bin/kill -s HUP $MAINPID

LimitNOFILE=infinity

LimitNPROC=infinity

LimitCORE=infinity

TimeoutStartSec=0

Delegate=yes

KillMode=process

Restart=on-failure

StartLimitBurst=3

StartLimitInterval=60s

[Install]

WantedBy=multi-user.target

从其他节点拷贝证书文件到node1和2上:因为node1和2上没有证书,但是flanel需要证书

# mkdir -pv /opt/etcd/ssl/

# scp /opt/etcd/ssl/* k8s-node2:/opt/etcd/ssl/

重启flannel和docker:

# systemctl daemon-reload

# systemctl start flanneld

# systemctl enable flanneld

# systemctl restart docker

检查是否生效:

# ps -ef |grep docker

root 20941 1 1 Jun28 ? 09:15:34 /usr/bin/dockerd --bip=172.17.34.1/24 --ip-masq=false --mtu=1450

# ip addr

3607: flannel.1: <BROADCAST,MULTICAST,UP,LOWER_UP> mtu 1450 qdisc noqueue state UNKNOWN

link/ether 8a:2e:3d:09:dd:82 brd ff:ff:ff:ff:ff:ff

inet 172.17.34.0/32 scope global flannel.1

valid_lft forever preferred_lft forever

3608: docker0: <BROADCAST,MULTICAST,UP,LOWER_UP> mtu 1450 qdisc noqueue state UP

link/ether 02:42:31:8f:d3:02 brd ff:ff:ff:ff:ff:ff

inet 172.17.34.1/24 brd 172.17.34.255 scope global docker0

valid_lft forever preferred_lft forever

inet6 fe80::42:31ff:fe8f:d302/64 scope link

valid_lft forever preferred_lft forever

确保docker0与flannel.1在同一网段。

测试不同节点互通,在当前节点访问另一个Node节点docker0 IP:

# ping 172.17.58.1

PING 172.17.58.1 (172.17.58.1) 56(84) bytes of data.

64 bytes from 172.17.58.1: icmp_seq=1 ttl=64 time=0.263 ms

64 bytes from 172.17.58.1: icmp_seq=2 ttl=64 time=0.204 ms

如果能通说明Flannel部署成功。如果不通检查下日志:journalctl -u flannel

部署kubernetes 集群-二进制方式(二)

在Master节点部署组件

两个Master节点部署方式一样

在部署Kubernetes之前一定要确保etcd、flannel、docker是正常工作的,否则先解决问题再继续。

生成证书

创建CA证书:

# cat ca-config.json

{

"signing": {

"default": {

"expiry": "87600h"

},

"profiles": {

"kubernetes": {

"expiry": "87600h",

"usages": [

"signing",

"key encipherment",

"server auth",

"client auth"

]

}

}

}

}

# cat ca-csr.json

{

"CN": "kubernetes",

"key": {

"algo": "rsa",

"size": 2048

},

"names": [

{

"C": "CN",

"L": "Beijing",

"ST": "Beijing",

"O": "k8s",

"OU": "System"

}

]

}

# cfssl gencert -initca ca-csr.json | cfssljson -bare ca -

生成apiserver证书:

# cat server-csr.json

{

"CN": "kubernetes",

"hosts": [

"10.0.0.1", //这个是后边dns要用的虚拟网络的网关,不用改,就用这个 切忌

"127.0.0.1",

"10.206.176.19",

"10.206.240.188",

"10.206.240.189",

"kubernetes",

"kubernetes.default",

"kubernetes.default.svc",

"kubernetes.default.svc.cluster",

"kubernetes.default.svc.cluster.local"

],

"key": {

"algo": "rsa",

"size": 2048

},

"names": [

{

"C": "CN",

"L": "BeiJing",

"ST": "BeiJing",

"O": "k8s",

"OU": "System"

}

]

}

# cfssl gencert -ca=ca.pem -ca-key=ca-key.pem -config=ca-config.json -profile=kubernetes server-csr.json | cfssljson -bare server

生成kube-proxy证书:

# cat kube-proxy-csr.json

{

"CN": "system:kube-proxy",

"hosts": [],

"key": {

"algo": "rsa",

"size": 2048

},

"names": [

{

"C": "CN",

"L": "BeiJing",

"ST": "BeiJing",

"O": "k8s",

"OU": "System"

}

]

}

# cfssl gencert -ca=ca.pem -ca-key=ca-key.pem -config=ca-config.json -profile=kubernetes kube-proxy-csr.json | cfssljson -bare kube-proxy

最终生成以下证书文件:

# ls *pem

ca-key.pem ca.pem kube-proxy-key.pem kube-proxy.pem server-key.pem server.pem

部署apiserver组件

下载二进制包:https://github.com/kubernetes/kubernetes/blob/master/CHANGELOG-1.11.md

下载这个包(kubernetes-server-linux-amd64.tar.gz)就够了,包含了所需的所有组件。

[https://dl.k8s.io/v1.11.0/kubernetes-server-linux-amd64.tar.gz]

# mkdir /opt/kubernetes/{bin,cfg,ssl} -pv

# tar zxvf kubernetes-server-linux-amd64.tar.gz

# cd kubernetes/server/bin

# cp kube-apiserver kube-scheduler kube-controller-manager kubectl /opt/kubernetes/bin

从生成证书的机器拷贝证书到master1,master2:

# scp server.pem server-key.pem ca.pem ca-key.pem k8s-master1:/opt/kubernetes/ssl/

# scp server.pem server-key.pem ca.pem ca-key.pem k8s-master2:/opt/kubernetes/ssl/

创建token文件,后面会讲到:

# cat /opt/kubernetes/cfg/token.csv

674c457d4dcf2eefe4920d7dbb6b0ddc,kubelet-bootstrap,10001,"system:kubelet-bootstrap"

第一列:随机字符串,自己可生成

第二列:用户名

第三列:UID

第四列:用户组

创建apiserver配置文件:

# cat /opt/kubernetes/cfg/kube-apiserver

KUBE_APISERVER_OPTS="--logtostderr=true \

--v=4 \

--etcd-servers=https://10.206.240.189:2379,https://10.206.240.188:2379,https://10.206.240.111:2379 \

--bind-address=10.206.240.189 \

--secure-port=6443 \

--advertise-address=10.206.240.189 \

--allow-privileged=true \

--service-cluster-ip-range=10.0.0.0/24 \

--enable-admission-plugins=NamespaceLifecycle,LimitRanger,ServiceAccount,ResourceQuota,NodeRestriction \

--authorization-mode=RBAC,Node \

--enable-bootstrap-token-auth \

--token-auth-file=/opt/kubernetes/cfg/token.csv \

--service-node-port-range=30000-50000 \

--tls-cert-file=/opt/kubernetes/ssl/server.pem \

--tls-private-key-file=/opt/kubernetes/ssl/server-key.pem \

--client-ca-file=/opt/kubernetes/ssl/ca.pem \

--service-account-key-file=/opt/kubernetes/ssl/ca-key.pem \

--etcd-cafile=/opt/etcd/ssl/ca.pem \

--etcd-certfile=/opt/etcd/ssl/server.pem \

--etcd-keyfile=/opt/etcd/ssl/server-key.pem"

配置好前面生成的证书,确保能连接etcd。

参数说明:

* --logtostderr 启用日志

* --v 日志等级

* --etcd-servers etcd集群地址

* --bind-address 监听地址

* --secure-port https安全端口

* --advertise-address 集群通告地址

* --allow-privileged 启用授权

* --service-cluster-ip-range Service虚拟IP地址段 //这里就用这个网段,切忌不要改

* --enable-admission-plugins 准入控制模块

* --authorization-mode 认证授权,启用RBAC授权和节点自管理

* --enable-bootstrap-token-auth 启用TLS bootstrap功能,后面会讲到

* --token-auth-file token文件

* --service-node-port-range Service Node类型默认分配端口范围

systemd管理apiserver:

# cat /usr/lib/systemd/system/kube-apiserver.service

[Unit]

Description=Kubernetes API Server

Documentation=https://github.com/kubernetes/kubernetes

[Service]

EnvironmentFile=-/opt/kubernetes/cfg/kube-apiserver

ExecStart=/opt/kubernetes/bin/kube-apiserver $KUBE_APISERVER_OPTS

Restart=on-failure

[Install]

WantedBy=multi-user.target

启动:

# systemctl daemon-reload

# systemctl enable kube-apiserver

# systemctl start kube-apiserver

部署schduler组件

创建schduler配置文件:

# cat /opt/kubernetes/cfg/kube-scheduler

KUBE_SCHEDULER_OPTS="--logtostderr=true \

--v=4 \

--master=127.0.0.1:8080 \

--leader-elect"

参数说明:

* --master 连接本地apiserver

* --leader-elect 当该组件启动多个时,自动选举(HA)

systemd管理schduler组件:

# cat /usr/lib/systemd/system/kube-scheduler.service

[Unit]

Description=Kubernetes Scheduler

Documentation=https://github.com/kubernetes/kubernetes

[Service]

EnvironmentFile=-/opt/kubernetes/cfg/kube-scheduler

ExecStart=/opt/kubernetes/bin/kube-scheduler $KUBE_SCHEDULER_OPTS

Restart=on-failure

[Install]

WantedBy=multi-user.target

启动:

# systemctl daemon-reload

# systemctl enable kube-scheduler

# systemctl start kube-scheduler

部署controller-manager组件

创建controller-manager配置文件:

# cat /opt/kubernetes/cfg/kube-controller-manager

KUBE_CONTROLLER_MANAGER_OPTS="--logtostderr=true \

--v=4 \

--master=127.0.0.1:8080 \

--leader-elect=true \

--address=127.0.0.1 \

--service-cluster-ip-range=10.0.0.0/24 \

--cluster-name=kubernetes \

--cluster-signing-cert-file=/opt/kubernetes/ssl/ca.pem \

--cluster-signing-key-file=/opt/kubernetes/ssl/ca-key.pem \

--root-ca-file=/opt/kubernetes/ssl/ca.pem \

--service-account-private-key-file=/opt/kubernetes/ssl/ca-key.pem"

systemd管理controller-manager组件:

# cat /usr/lib/systemd/system/kube-controller-manager.service

[Unit]

Description=Kubernetes Controller Manager

Documentation=https://github.com/kubernetes/kubernetes

[Service]

EnvironmentFile=-/opt/kubernetes/cfg/kube-controller-manager

ExecStart=/opt/kubernetes/bin/kube-controller-manager $KUBE_CONTROLLER_MANAGER_OPTS

Restart=on-failure

[Install]

WantedBy=multi-user.target

启动:

# systemctl daemon-reload

# systemctl enable kube-controller-manager

# systemctl start kube-controller-manager

所有组件都已经启动成功,通过kubectl工具查看当前集群组件状态:

# /opt/kubernetes/bin/kubectl get cs

NAME STATUS MESSAGE ERROR

scheduler Healthy ok

etcd-0 Healthy {"health":"true"}

etcd-2 Healthy {"health":"true"}

etcd-1 Healthy {"health":"true"}

controller-manager Healthy ok

如上输出说明组件都正常。

-------

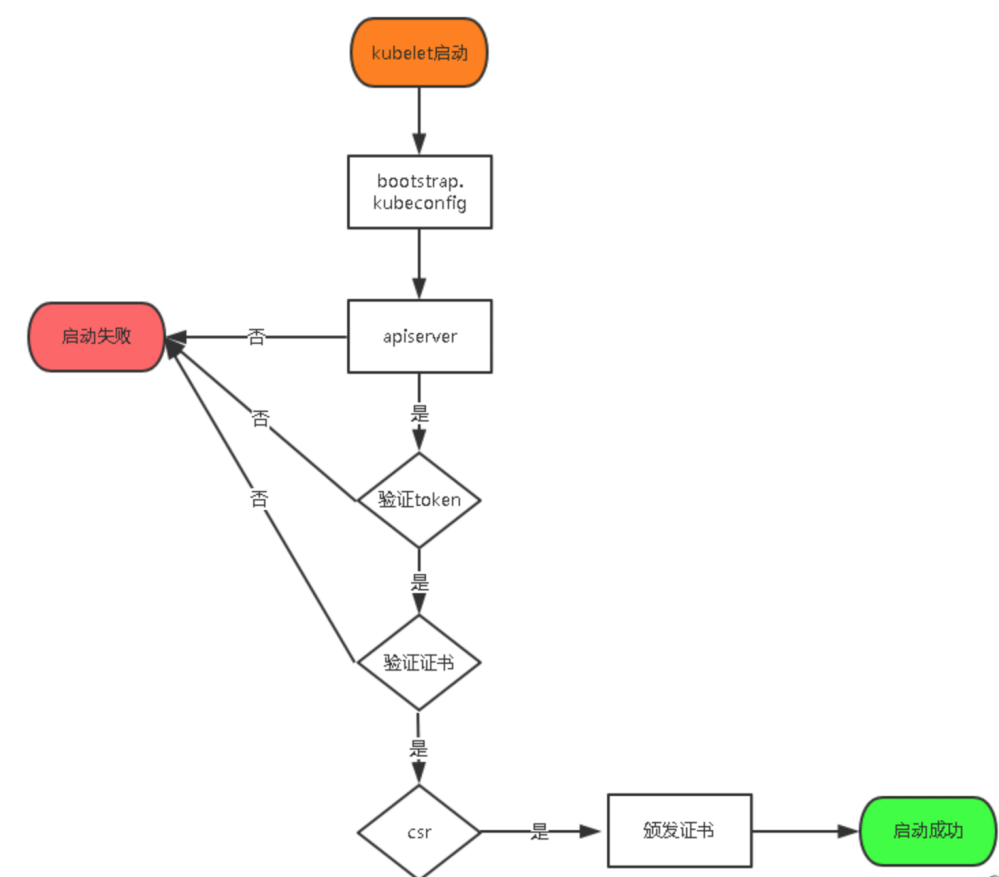

在Node节点部署组件

Master apiserver启用TLS认证后,Node节点kubelet组件想要加入集群,必须使用CA签发的有效证书才能与apiserver通信,当Node节点很多时,签署证书是一件很繁琐的事情,因此有了TLS Bootstrapping机制,kubelet会以一个低权限用户自动向apiserver申请证书,kubelet的证书由apiserver动态签署。

----------------------下面这些操作在master节点完成:---------------------------

将kubelet-bootstrap用户绑定到系统集群角色

# /opt/kubernetes/bin/kubectl create clusterrolebinding kubelet-bootstrap \

--clusterrole=system:node-bootstrapper \

--user=kubelet-bootstrap

创建kubeconfig文件:

在生成kubernetes证书的目录下执行以下命令生成kubeconfig文件:

指定apiserver 内网负载均衡地址

# KUBE_APISERVER="https://10.206.176.19:6443"

# BOOTSTRAP_TOKEN=674c457d4dcf2eefe4920d7dbb6b0ddc

# 设置集群参数

# /opt/kubernetes/bin/kubectl config set-cluster kubernetes \

--certificate-authority=./ca.pem \

--embed-certs=true \

--server=${KUBE_APISERVER} \

--kubeconfig=bootstrap.kubeconfig

# 设置客户端认证参数

# /opt/kubernetes/bin/kubectl config set-credentials kubelet-bootstrap \

--token=${BOOTSTRAP_TOKEN} \

--kubeconfig=bootstrap.kubeconfig

# 设置上下文参数

# /opt/kubernetes/bin/kubectl config set-context default \

--cluster=kubernetes \

--user=kubelet-bootstrap \

--kubeconfig=bootstrap.kubeconfig

# 设置默认上下文

# /opt/kubernetes/bin/kubectl config use-context default --kubeconfig=bootstrap.kubeconfig

#----------------------

# 创建kube-proxy kubeconfig文件

# /opt/kubernetes/bin/kubectl config set-cluster kubernetes \

--certificate-authority=./ca.pem \

--embed-certs=true \

--server=${KUBE_APISERVER} \

--kubeconfig=kube-proxy.kubeconfig

# /opt/kubernetes/bin/kubectl config set-credentials kube-proxy \

--client-certificate=./kube-proxy.pem \

--client-key=./kube-proxy-key.pem \

--embed-certs=true \

--kubeconfig=kube-proxy.kubeconfig

# /opt/kubernetes/bin/kubectl config set-context default \

--cluster=kubernetes \

--user=kube-proxy \

--kubeconfig=kube-proxy.kubeconfig

# /opt/kubernetes/bin/kubectl config use-context default --kubeconfig=kube-proxy.kubeconfig

# ls

bootstrap.kubeconfig kube-proxy.kubeconfig

将这两个文件拷贝到Node节点/opt/kubernetes/cfg目录下。 !!!!不能忽略

----------------------下面这些操作在所有node节点完成:---------------------------

部署kubelet组件

mkdir /opt/kubernetes/{bin,cfg,ssl} -pv

将前面下载的二进制包中的kubelet和kube-proxy拷贝到/opt/kubernetes/bin目录下。 !!!不能忽略

创建kubelet配置文件:

# vim /opt/kubernetes/cfg/kubelet

KUBELET_OPTS="--logtostderr=true \

--v=4 \

--hostname-override=10.206.240.112 \

--kubeconfig=/opt/kubernetes/cfg/kubelet.kubeconfig \

--bootstrap-kubeconfig=/opt/kubernetes/cfg/bootstrap.kubeconfig \

--config=/opt/kubernetes/cfg/kubelet.config \

--cert-dir=/opt/kubernetes/ssl \

--pod-infra-container-image=registry.cn-hangzhou.aliyuncs.com/google-containers/pause-amd64:3.0"

参数说明:

* --hostname-override 在集群中显示的主机名

* --kubeconfig 指定kubeconfig文件位置,会自动生成

* --bootstrap-kubeconfig 指定刚才生成的bootstrap.kubeconfig文件

* --cert-dir 颁发证书存放位置

* --pod-infra-container-image 管理Pod网络的镜像

其中/opt/kubernetes/cfg/kubelet.config配置文件如下:

# vim /opt/kubernetes/cfg/kubelet.config

kind: KubeletConfiguration

apiVersion: kubelet.config.k8s.io/v1beta1

address: 10.206.240.112

port: 10250

readOnlyPort: 10255

cgroupDriver: cgroupfs

clusterDNS: ["10.0.0.2"]

clusterDomain: cluster.local.

failSwapOn: false

authentication:

anonymous:

enabled: true

webhook:

enabled: false

注释: clusterDns: //不要改,就是这个ip

systemd管理kubelet组件:

# vim /usr/lib/systemd/system/kubelet.service

[Unit]

Description=Kubernetes Kubelet

After=docker.service

Requires=docker.service

[Service]

EnvironmentFile=/opt/kubernetes/cfg/kubelet

ExecStart=/opt/kubernetes/bin/kubelet $KUBELET_OPTS

Restart=on-failure

KillMode=process

[Install]

WantedBy=multi-user.target

启动:

# systemctl daemon-reload

# systemctl enable kubelet

# systemctl start kubelet

在Master审批Node加入集群:

启动后还没加入到集群中,需要手动允许该节点才可以。

在Master节点查看请求签名的Node:

# /opt/kubernetes/bin/kubectl get csr

# /opt/kubernetes/bin/kubectl certificate approve XXXXID

# /opt/kubernetes/bin/kubectl get node

部署kube-proxy组件

创建kube-proxy配置文件:

# cat /opt/kubernetes/cfg/kube-proxy

KUBE_PROXY_OPTS="--logtostderr=true \

--v=4 \

--hostname-override=10.206.240.111 \

--cluster-cidr=10.0.0.0/24 \

--kubeconfig=/opt/kubernetes/cfg/kube-proxy.kubeconfig"

注释: --cluster-cidr //不要改,就是这个ip

systemd管理kube-proxy组件:

# cat /usr/lib/systemd/system/kube-proxy.service

[Unit]

Description=Kubernetes Proxy

After=network.target

[Service]

EnvironmentFile=-/opt/kubernetes/cfg/kube-proxy

ExecStart=/opt/kubernetes/bin/kube-proxy $KUBE_PROXY_OPTS

Restart=on-failure

[Install]

WantedBy=multi-user.target

启动:

# systemctl daemon-reload

# systemctl enable kube-proxy

# systemctl start kube-proxy

查看集群状态

# /opt/kubernetes/bin/kubectl get node

NAME STATUS ROLES AGE VERSION

10.206.240.111 Ready <none> 28d v1.11.0

10.206.240.112 Ready <none> 28d v1.11.0

# /opt/kubernetes/bin/kubectl get cs

NAME STATUS MESSAGE ERROR

controller-manager Healthy ok

scheduler Healthy ok

etcd-2 Healthy {"health":"true"}

etcd-1 Healthy {"health":"true"}

etcd-0 Healthy {"health":"true"}

运行一个测试示例

创建一个Nginx Web,判断集群是否正常工作:

# /opt/kubernetes/bin/kubectl run nginx --image=nginx --replicas=3

# /opt/kubernetes/bin/kubectl expose deployment nginx --port=88 --target-port=80 --type=NodePort

查看Pod,Service:

# /opt/kubernetes/bin/kubectl get pods

NAME READY STATUS RESTARTS AGE

nginx-64f497f8fd-fjgt2 1/1 Running 3 28d

nginx-64f497f8fd-gmstq 1/1 Running 3 28d

nginx-64f497f8fd-q6wk9 1/1 Running 3 28d

查看pod详细信息:

# /opt/kubernetes/bin/kubectl describe pod nginx-64f497f8fd-fjgt2

# /opt/kubernetes/bin/kubectl get svc

NAME TYPE CLUSTER-IP EXTERNAL-IP PORT(S) AGE

kubernetes ClusterIP 10.0.0.1 <none> 443/TCP 28d

nginx NodePort 10.0.0.175 <none> 88:38696/TCP 28d

打开浏览器输入:http://10.206.240.111:38696

恭喜你,集群部署成功!

---

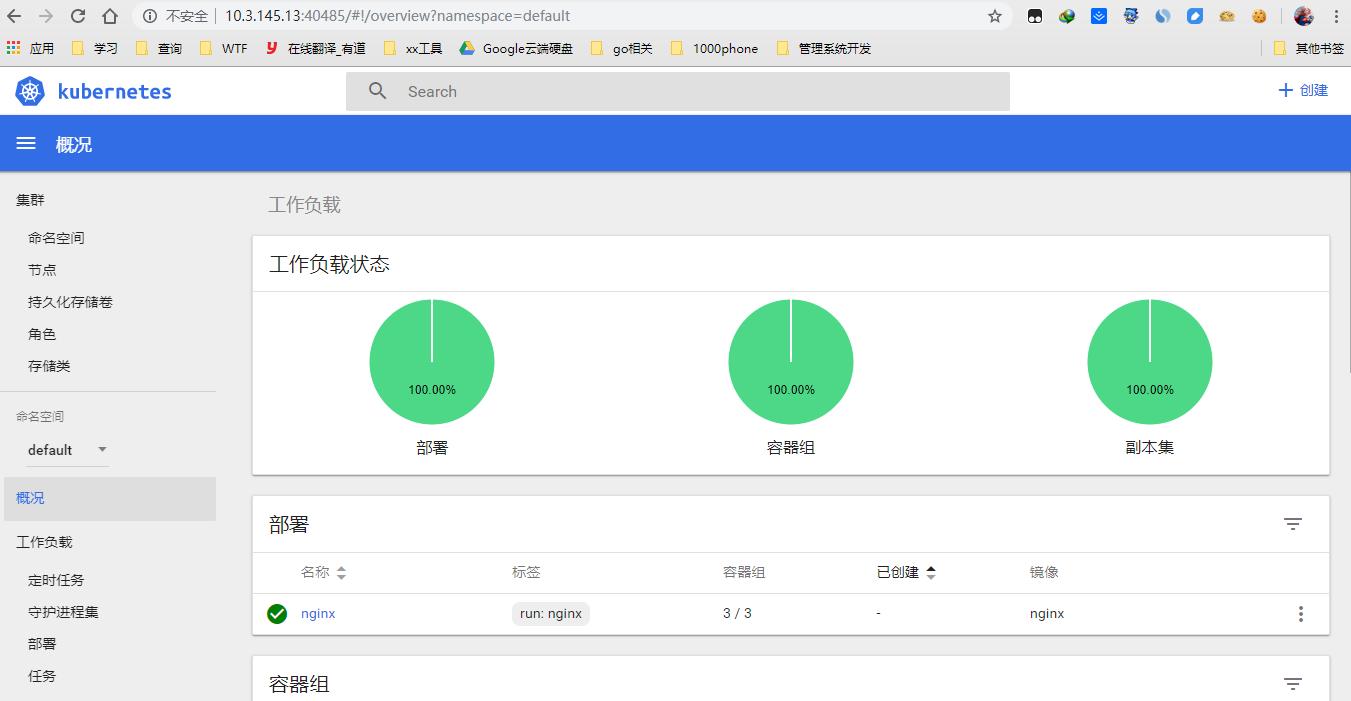

部署Dashboard (web UI)

部署Dashboard(Web UI)

部署UI有三个文件:

* dashboard-deployment.yaml // 部署Pod,提供Web服务

* dashboard-rbac.yaml // 授权访问apiserver获取信息

* dashboard-service.yaml // 发布服务,提供对外访问

# cat dashboard-deployment.yaml

apiVersion: apps/v1beta2

kind: Deployment

metadata:

name: kubernetes-dashboard

namespace: kube-system

labels:

k8s-app: kubernetes-dashboard

kubernetes.io/cluster-service: "true"

addonmanager.kubernetes.io/mode: Reconcile

spec:

selector:

matchLabels:

k8s-app: kubernetes-dashboard

template:

metadata:

labels:

k8s-app: kubernetes-dashboard

annotations:

scheduler.alpha.kubernetes.io/critical-pod: ''

spec:

serviceAccountName: kubernetes-dashboard

containers:

- name: kubernetes-dashboard

image: registry.cn-hangzhou.aliyuncs.com/kube_containers/kubernetes-dashboard-amd64:v1.8.1

resources:

limits:

cpu: 100m

memory: 300Mi

requests:

cpu: 100m

memory: 100Mi

ports:

- containerPort: 9090

protocol: TCP

livenessProbe:

httpGet:

scheme: HTTP

path: /

port: 9090

initialDelaySeconds: 30

timeoutSeconds: 30

tolerations:

- key: "CriticalAddonsOnly"

operator: "Exists"

# cat dashboard-rbac.yaml

apiVersion: v1

kind: ServiceAccount

metadata:

labels:

k8s-app: kubernetes-dashboard

addonmanager.kubernetes.io/mode: Reconcile

name: kubernetes-dashboard

namespace: kube-system

---

kind: ClusterRoleBinding

apiVersion: rbac.authorization.k8s.io/v1beta1

metadata:

name: kubernetes-dashboard-minimal

namespace: kube-system

labels:

k8s-app: kubernetes-dashboard

addonmanager.kubernetes.io/mode: Reconcile

roleRef:

apiGroup: rbac.authorization.k8s.io

kind: ClusterRole

name: cluster-admin

subjects:

- kind: ServiceAccount

name: kubernetes-dashboard

namespace: kube-system

# cat dashboard-service.yaml

apiVersion: v1

kind: Service

metadata:

name: kubernetes-dashboard

namespace: kube-system

labels:

k8s-app: kubernetes-dashboard

kubernetes.io/cluster-service: "true"

addonmanager.kubernetes.io/mode: Reconcile

spec:

type: NodePort

selector:

k8s-app: kubernetes-dashboard

ports:

- port: 80

targetPort: 9090

创建:

# /opt/kubernetes/bin/kubectl create -f dashboard-rbac.yaml

# /opt/kubernetes/bin/kubectl create -f dashboard-deployment.yaml

# /opt/kubernetes/bin/kubectl create -f dashboard-service.yaml

等待数分钟,查看资源状态:

# /opt/kubernetes/bin/kubectl get all -n kube-system

NAME READY STATUS RESTARTS AGE

pod/kubernetes-dashboard-68ff5fcd99-5rtv7 1/1 Running 1 27d

NAME TYPE CLUSTER-IP EXTERNAL-IP PORT(S) AGE

service/kubernetes-dashboard NodePort 10.0.0.100 <none> 443:30000/TCP 27d

NAME DESIRED CURRENT UP-TO-DATE AVAILABLE AGE

deployment.apps/kubernetes-dashboard 1 1 1 1 27d

NAME DESIRED CURRENT READY AGE

replicaset.apps/kubernetes-dashboard-68ff5fcd99 1 1 1 27d

查看访问端口:

# /opt/kubernetes/bin/kubectl get svc -n kube-system

NAME TYPE CLUSTER-IP EXTERNAL-IP PORT(S) AGE

kubernetes-dashboard NodePort 10.0.0.100 <none> 443:30000/TCP 27d

打开浏览器,输入:http://10.206.240.111:30000

===============================

其他部署方式dashboard -- 未测试过

# /opt/kubernetes/bin/kubectl apply -f https://raw.githubusercontent.com/kubernetes/dashboard/v1.10.1/src/deploy/recommended/kubernetes-dashboard.yaml

# /opt/kubernetes/bin/kubectl delete -f https://raw.githubusercontent.com/kubernetes/dashboard/v1.10.1/src/deploy/recommended/kubernetes-dashboard.yaml

To access Dashboard from your local workstation you must create a secure channel to your Kubernetes cluster. Run the following command:

$ kubectl proxy

Now access Dashboard at:

http://localhost:8001/api/v1/namespaces/kube-system/services/https:kubernetes-dashboard:/proxy/.

kubeadm方式部署Kubernetes

kubeadm是官方社区推出的一个用于快速部署kubernetes集群的工具。

这个工具能通过两条指令完成一个kubernetes集群的部署:

# 创建一个 Master 节点

$ kubeadm init

# 将一个 Node 节点加入到当前集群中

$ kubeadm join <Master节点的IP和端口 >

1. 安装要求

在开始之前,部署Kubernetes集群机器需要满足以下几个条件:

- 一台或多台机器,操作系统 CentOS7.x-86_x64

- 硬件配置:2GB或更多RAM,2个CPU或更多CPU,硬盘30GB或更多

- 集群中所有机器之间网络互通

- 可以访问外网,需要拉取镜像

- 禁止swap分区

2.学习目标

- 在所有节点上安装Docker和kubeadm

- 部署Kubernetes Master

- 部署容器网络插件

- 部署 Kubernetes Node,将节点加入Kubernetes集群中

- 部署Dashboard Web页面,可视化查看Kubernetes资源

3. 准备环境

Kubernetes 架构图

关闭防火墙:

systemctl stop firewalld

systemctl disable firewalld

关闭selinux:

sed -i 's/enforcing/disabled/' /etc/selinux/config

setenforce 0

关闭swap:

$ swapoff -a $ 临时

$ vim /etc/fstab $ 永久

添加主机名与IP对应关系(记得设置主机名):

$ cat /etc/hosts

192.168.31.63 k8s-master

192.168.31.65 k8s-node1

192.168.31.66 k8s-node2

hostnamectl set-hostname hostname

将桥接的IPv4流量传递到iptables的链:

$ cat > /etc/sysctl.d/k8s.conf << EOF

net.bridge.bridge-nf-call-ip6tables = 1

net.bridge.bridge-nf-call-iptables = 1

EOF

$ sysctl --system

4. 所有节点安装Docker/kubeadm/kubelet

Kubernetes默认CRI(容器运行时)为Docker,因此先安装Docker。

4.1 安装Docker

$ wget https://mirrors.aliyun.com/docker-ce/linux/centos/docker-ce.repo -O /etc/yum.repos.d/docker-ce.repo

$ yum -y install docker-ce-20.10.7-3.el7

$ systemctl enable docker && systemctl start docker

$ docker --version

Docker version 20.10.7, build f0df350

4.2 添加阿里云YUM软件源

$ cat > /etc/yum.repos.d/kubernetes.repo << EOF

[kubernetes]

name=Kubernetes

baseurl=https://mirrors.aliyun.com/kubernetes/yum/repos/kubernetes-el7-x86_64

enabled=1

gpgcheck=1

repo_gpgcheck=1

gpgkey=https://mirrors.aliyun.com/kubernetes/yum/doc/yum-key.gpg https://mirrors.aliyun.com/kubernetes/yum/doc/rpm-package-key.gpg

EOF

4.3 安装kubeadm,kubelet和kubectl

由于版本更新频繁,这里指定版本号部署:

$ yum install -y kubelet-1.14.0 kubeadm-1.14.0 kubectl-1.14.0

$ systemctl enable kubelet

5. 部署Kubernetes Master

在192.168.31.63(Master)执行。

$ kubeadm init \

--apiserver-advertise-address=192.168.31.63 \

--image-repository registry.aliyuncs.com/google_containers \

--kubernetes-version v1.14.0 \

--service-cidr=10.1.0.0/16 \

--pod-network-cidr=10.244.0.0/16

由于默认拉取镜像地址k8s.gcr.io国内无法访问,这里指定阿里云镜像仓库地址。

使用kubectl工具:

mkdir -p $HOME/.kube

sudo cp -i /etc/kubernetes/admin.conf $HOME/.kube/config

sudo chown $(id -u):$(id -g) $HOME/.kube/config

$ kubectl get nodes

6. 安装Pod网络插件(CNI)

$ kubectl apply -f https://raw.githubusercontent.com/coreos/flannel/a70459be0084506e4ec919aa1c114638878db11b/Documentation/kube-flannel.yml [1.14]

https://raw.githubusercontent.com/coreos/flannel/master/Documentation/kube-flannel.yml [1.16]

确保能够访问到quay.io这个registery。 master执行

# kubectl get pods -n kube-system

7. 加入Kubernetes Node

在192.168.31.65/66(Node)执行。

向集群添加新节点,执行在kubeadm init输出的kubeadm join命令:

$ kubeadm join 192.168.31.63:6443 --token l79g5t.6ov4jkddwqki1dxe --discovery-token-ca-cert-hash sha256:4f07f9068c543130461c9db368d62b4aabc22105451057f887defa35f47fa076

8. 测试kubernetes集群

在Kubernetes集群中创建一个pod,验证是否正常运行:

$ kubectl create deployment nginx --image=nginx

$ kubectl expose deployment nginx --port=80 --type=NodePort

$ kubectl get pod,svc

$ kubectl get pod,svc -o wide

访问地址:http://NodeIP:Port

9. 部署 Dashboard

$ kubectl apply -f https://raw.githubusercontent.com/kubernetes/dashboard/v1.10.1/src/deploy/recommended/kubernetes-dashboard.yaml

镜像下载因为网络的原因:

镜像难以下载,需要修改以下两个地方

image: tigerfive/kubernetes-dashboard-amd64:v1.10.1

spec:

type: NodePort

ports:

- port: 443

targetPort: 8443

nodePort: 30001

默认Dashboard只能集群内部访问,修改Service为NodePort类型,暴露到外部:

kind: Service

apiVersion: v1

metadata:

labels:

k8s-app: kubernetes-dashboard

name: kubernetes-dashboard

namespace: kube-system

spec:

type: NodePort

ports:

- port: 443

targetPort: 8443

nodePort: 30001

selector:

k8s-app: kubernetes-dashboard

$ kubectl apply -f kubernetes-dashboard.yaml

访问地址:https://NodeIP:30001

创建service account并绑定默认cluster-admin管理员集群角色:

$ kubectl create serviceaccount dashboard-admin -n kube-system

$ kubectl create clusterrolebinding dashboard-admin --clusterrole=cluster-admin --serviceaccount=kube-system:dashboard-admin

$ kubectl describe secrets -n kube-system $(kubectl -n kube-system get secret | awk '/dashboard-admin/{print $1}')

使用输出的token登录Dashboard。

9. 部署 kuboard

部署

kubectl apply -f https://kuboard.cn/install-script/kuboard.yaml

kubectl apply -f https://addons.kuboard.cn/metrics-server/0.3.7/metrics-server.yaml

-----

[如果metric安装后报如下错误]

Error from server (ServiceUnavailable): the server is currently unable to handle the request (get pods.metrics.k8s.io)

则执行下列命令解决

kubectl create clusterrolebinding system:anonymous --clusterrole=cluster-admin --user=system:anonymous

--------

查看运行状态

kubectl get pods -l k8s.kuboard.cn/name=kuboard -n kube-system

输出结果如下所示:

NAME READY STATUS RESTARTS AGE

kuboard-54c9c4f6cb-6lf88 1/1 Running 0 45s

获取访问token

拥有的权限

此Token拥有 ClusterAdmin 的权限,可以执行所有操作

echo $(kubectl -n kube-system get secret $(kubectl -n kube-system get secret | grep kuboard-user | awk '{print $1}') -o go-template='{{.data.token}}' | base64 -d)

只读用户token

拥有的权限

view 可查看名称空间的内容

system:node 可查看节点信息

system:persistent-volume-provisioner 可查看存储类和存储卷声明的信息

适用场景

只读用户不能对集群的配置执行修改操作,非常适用于将开发环境中的 Kuboard 只读权限分发给开发者,以便开发者可以便捷地诊断问题

执行命令

执行如下命令可以获得 只读用户 的 Token

echo $(kubectl -n kube-system get secret $(kubectl -n kube-system get secret | grep kuboard-viewer | awk '{print $1}') -o go-template='{{.data.token}}' | base64 -d)

访问Kuboard

Kuboard Service 使用了 NodePort 的方式暴露服务,NodePort 为 32567;您可以按如下方式访问 Kuboard。

http://任意一个Worker节点的IP地址:32567/

输入前一步骤中获得的 token,可进入 Kuboard 集群概览页

为 kubernetes 集群提供企业级本地镜像仓库

registry库

生产环境下,势必不能够每个机器都导入一遍从海外下载回来的镜像,这方法都不是可以长期使用的。

可以通过搭建本地的私有镜像仓库(docker registry,这个镜像可以在国内直接下载)来解决这个问题。

注:除了第3、4步,其他部署本地仓库的方法和讲docker的时候方法是一样一样的

1、部署docker registry

在master上搭建registry。

1.1 拉取registry镜像

# docker pull docker.io/registry

# docker images

REPOSITORY TAG IMAGE ID CREATED SIZE

docker.io/registry latest d1e32b95d8e8 4 weeks ago 33.17 MB

1.2 启动registry

# docker run -d -p 5000:5000 --name=registry --restart=always --privileged=true --log-driver=none -v /home/data/registrydata:/tmp/registry registry

其中,/home/data/registrydata是一个比较大的系统分区,今后镜像仓库中的全部数据都会保存在这个外挂目录下。

里边的 /tmp/registry 在我下载的镜像中对应的是:/var/lib/registry,如果不确定是那个目录,大家最好使用 docker inspect registry查看一下Image相关的信息!

2、更改名称并推送

[root@K8s-node-2 ~]# docker images

REPOSITORY TAG IMAGE ID CREATED SIZE

registry.access.redhat.com/rhel7/pod-infrastructure latest 34d3450d733b 2 weeks ago 205 MB

gcr.io/google_containers/kubernetes-dashboard-amd64 v1.5.1 1180413103fd 5 weeks ago 103.6 MB

[root@K8s-node-2 ~]# docker tag registry.access.redhat.com/rhel7/pod-infrastructure:latest registry:5000/pod-infrastructure:latest

[root@K8s-node-2 ~]# docker tag gcr.io/google_containers/kubernetes-dashboard-amd64:v1.5.1 registry:5000/kubernetes-dashboard-amd64:v1.5.1

[root@K8s-node-2 ~]# docker push registry:5000/pod-infrastructure:latest

[root@K8s-node-2 ~]# docker push registry:5000/kubernetes-dashboard-amd64:v1.5.1

[root@K8s-node-2 ~]# docker images

REPOSITORY TAG IMAGE ID CREATED SIZE

registry.access.redhat.com/rhel7/pod-infrastructure latest 34d3450d733b 2 weeks ago 205 MB

registry:5000/pod-infrastructure latest 34d3450d733b 2 weeks ago 205 MB

gcr.io/google_containers/kubernetes-dashboard-amd64 v1.5.1 1180413103fd 5 weeks ago 103.6 MB

registry:5000/kubernetes-dashboard-amd64 v1.5.1 1180413103fd 5 weeks ago 103.6 MB

gcr.io/google_containers/kubedns-amd64 1.7 bec33bc01f03 5 months ago 55.06 MB

3、更改所使用的镜像名称

Dashboard是在yaml中定义的,要更改dashboard.yaml中对应的"image: gcr.io/google_containers/kubernetes-dashboard-amd64:v1.5.1"为"image: registry:5000/kubernetes-dashboard-amd64:v1.5.1"

pod-infrastructure是在node的kubelet配置文件中定义的:

要更改每个node中/etc/kubernetes/kubelet中对应的:

"KUBELET_POD_INFRA_CONTAINER="--pod-infra-container-image=registry.access.redhat.com/rhel7/pod-infrastructure:latest"

为"KUBELET_POD_INFRA_CONTAINER="--pod-infra-container-image= registry:5000/pod-infrastructure:latest ""。

更改之后需要重启kubelet服务。

4、重建dashboard应用

执行完上一节的"销毁应用"之后,再次执行"启动",即可完成dashboard的重建。

查看私有仓库里的所有镜像:

注意我这里是用的是ubuntu的例子

# curl 192.168.245.130:5000/v2/_catalog

{"repositories":["daocloud.io/ubuntu"]}

或者:

# curl http://192.168.245.130:5000/v2/daocloud.io/ubuntu/tags/list

{"name":"daocloud.io/ubuntu","tags":["v2"]}

Harbor仓库

Harbor简史

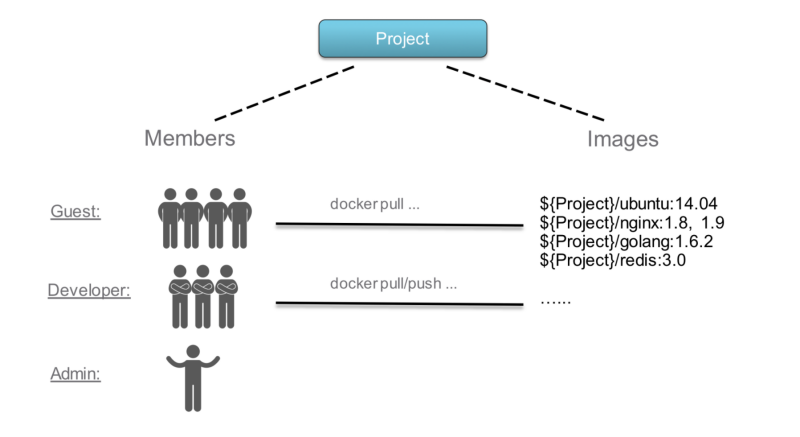

Harbor是由VMware公司开源的容器镜像仓库, 事实上, Harbor是在Docker Registry上进行了相应的企业级拓展, 从而获得了更加广泛的应用, 这些企业级拓展包括: 管理用户界面、基于角色访问控制、AD/LDAP集成以及审计日志, 足以满足基本企业需求.

Harbor主要功能

\1. 基于角色访问控制

在企业中, 通常有不同的开发团队负责不同的项目, 镜像像代码一样, 每个人角色不同需求也不同, 因此就需要访问权限控制, 根据角色分配相应的权限.

比如: 开发人员需要对项目构建这就用到读写权限(pull/push), 测试人员只需要读权限(pull), 运维一般管理镜像仓库, 具备权限分配能力, 项目经理具备所有权限

- Guest: 对指定项目只读权限

- Developer: 开发人员, 读写项目权限

- Admin: 项目管理, 所有权限

- Anonymous: 当用户未登陆时,该用户视为匿名, 不能访问私有项目, 只能访问公开项目

2.镜像复制

可以将仓库中的镜像同步到远程Harbor, 类似于MySQL的主从复制功能

3.镜像删除和空间回收

Harbor支持在web界面删除镜像, 回收无用的镜像, 释放磁盘空间

4.审计

对仓库的所有操作都有记录

- REST API

具备完整的API, 方便与外部集成

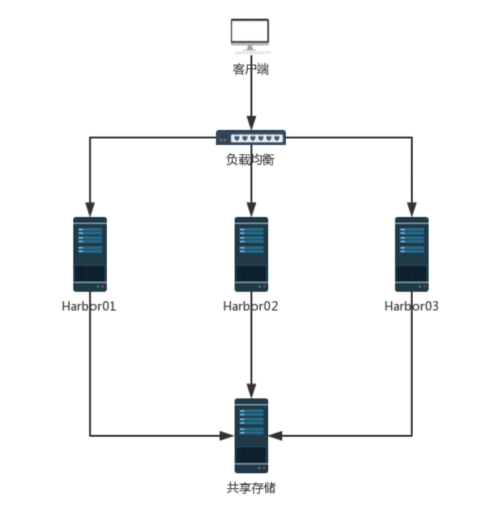

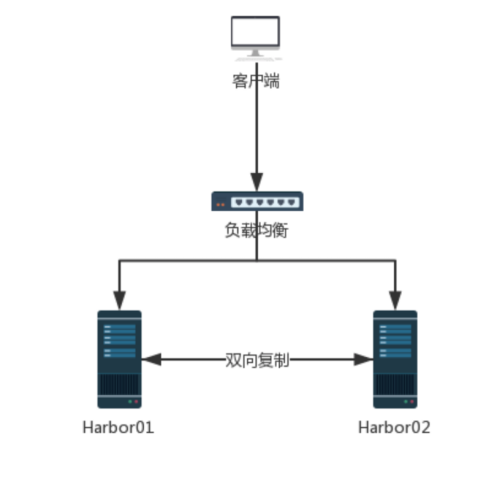

Harbor高可用方案

方案一: 共享存储

多个实例共享数据共享一个存储, 任何一个实例持久化存储的镜像, 其他实例都可以读取到, 通过前置负载均衡分发请求

方案二: 复制同步

利用镜像复制功能, 实现双向复制保持数据一致, 通过前置负载均衡分发请求

Harbor组件

组件 功能

harbor-adminserver 配置管理中心

harbor-db MySQL数据库

harbor-jobservice 负责镜像复制

harbor-log 记录操作日志

harbor-UI Web管理页面和API

nginx 前端代理, 负责前端页面和镜像的上传/下载/转发

redis 会话

registry 镜像

Harbor部署

环境准备

192.168.1.175 harbor

192.168.1.205 master

Harbor部署:https方式

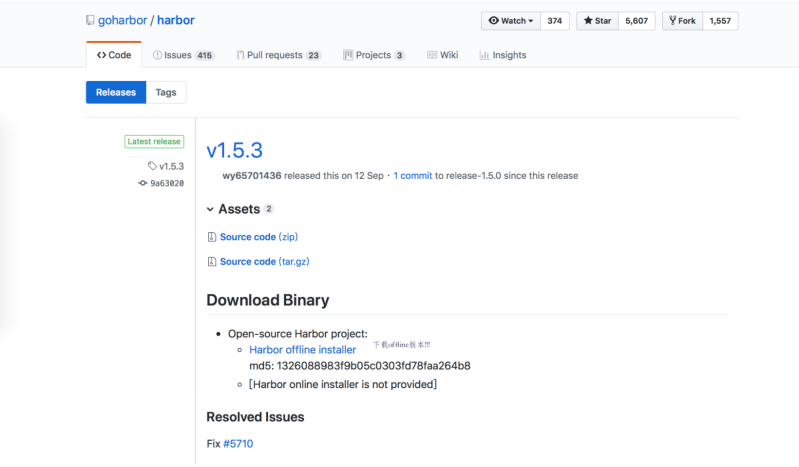

下载:https://storage.googleapis.com/harbor-releases/harbor-offline-installer-v1.5.3.tgz

下载此软件包需要翻墙, 请自行安装Google浏览器插件

部署docker

# curl -o /etc/yum.repos.d/docker-ce.repo https://mirrors.aliyun.com/docker-ce/linux/centos/docker-ce.repo

# yum -y install docker-ce

# curl -sSL https://get.daocloud.io/daotools/set_mirror.sh | sh -s http://bc437cce.m.daocloud.io

部署

GitHub:docker-compose1.22

# curl -L https://github.com/docker/compose/releases/download/1.22.0/docker-compose-`uname -s`-`uname -m` -o /usr/local/bin/docker-compose

# chmod a+x /usr/local/bin/docker-compose

或者

aliyun:docker-compose1.21

# curl -L https://mirrors.aliyun.com/docker-toolbox/linux/compose/1.21.2/docker-compose-Linux-x86_64 -o /usr/local/bin/docker-compose

# chmod a+x /usr/local/bin/docker-compose

自签发TLS证书

# mkdir /ca

# cd /ca

# openssl req \

-newkey rsa:4096 -nodes -sha256 -keyout ca.key \

-x509 -days 365 -out ca.crt

Country Name (2 letter code) [XX]:CN

State or Province Name (full name) []:BJ

Locality Name (eg, city) [Default City]:BJ

Organization Name (eg, company) [Default Company Ltd]:qianfeng

Organizational Unit Name (eg, section) []:yunjisuan

Common Name (eg, your name or your server's hostname) []:harbor

Email Address []:tiger@qq.com

# openssl req -newkey rsa:4096 -nodes -sha256 -keyout harbor.io.key -out harbor.io.csr

Country Name (2 letter code) [XX]:CN

State or Province Name (full name) []:BJ

Locality Name (eg, city) [Default City]:BJ

Organization Name (eg, company) [Default Company Ltd]:qianfeng

Organizational Unit Name (eg, section) []:yunjisuan

Common Name (eg, your name or your server's hostname) []:harbor

Email Address []:tiger@qq.com

Please enter the following 'extra' attributes

to be sent with your certificate request

A challenge password []:直接回车

An optional company name []:直接回车

# openssl x509 -req -days 365 -in harbor.io.csr -CA ca.crt -CAkey ca.key -CAcreateserial -out harbor.io.crt

部署配置

# tar xf harbor-offline-installer-v1.5.3.tgz

# cd harbor

# vim harbor.cfg //其他的不要改

hostname = harbor.io

ui_url_protocol = https

ssl_cert = /ca/harbor.io.crt

ssl_cert_key = /ca/harbor.io.key

方案二

# vim harbor.cfg //其他的不要改

hostname = 主机域名或IP

customize_crt = false

2.1之后不允许使用不安全模式,配置如下

# vim harbor.yml

hostname: 10.3.131.2

https:

# https port for harbor, default is 443

port: 443

# The path of cert and key files for nginx

certificate: /ca/harbor.io.crt

private_key: /ca/harbor.io.key

harbor_admin_password: Harbor12345

# ./prepare

# ./install.sh //如果重新安装,需要删除/data,删除已经load的docker镜像,然后重启docker

docker主机认证仓库

master:

# mkdir -p /etc/docker/certs.d/harbor.io

harbor:

# scp /ca/ca.crt master:/etc/docker/certs.d/harbor.io/

docker:

# docker login harbor.io

Username: admin

Password:Harbor12345

查看运行状态

# docker-compose ps

看到 harbor-adminserver、harbor-db、harbor-jobservice、harbor-log、harbor-ui、nginx、redis、registry都启动起来了就代表成功了

```

客户端

[20.10.7docker先修改该配置文件,重启测试是否可用,如果不可用,修改下列配置]

# cat /etc/docker/daemon.conf

{

"insecure-registries": ["http://10.3.131.2"]

}

# systemctl daemon-reload

# systemctl restart docker

server端:

[20.10.7docker先修改该配置文件,重启测试是否可用,如果不可用,修改下列配置]

[root@docker1 harbor]# cat /usr/lib/systemd/system/docker.service |grep ExecStart

ExecStart=/usr/bin/dockerd -H fd:// --insecure-registry 10.3.131.2 --containerd=/run/containerd/containerd.sock

# systemctl daemon-reload

# systemctl restart docker

# docker-compose down -v

# docker-compose up -d

# docker-compose ps

客户端测试

# docker login -u admin -p Harbor12345 http://10.3.131.2

WARNING! Using --password via the CLI is insecure. Use --password-stdin.

WARNING! Your password will be stored unencrypted in /root/.docker/config.json.

Configure a credential helper to remove this warning. See

https://docs.docker.com/engine/reference/commandline/login/#credentials-store

Login Succeeded

原因

这是因为docker1.3.2版本开始默认docker registry使用的是https,我们设置Harbor默认http方式,所以当执行用docker login、pull、push等命令操作非https的docker regsitry的时就会报错。

```

更新Harbor配置

docker-compose down -v

vim harbor.cfg ## 修改要更新的配置

./prepare

docker-compose up -d

Harbor使用

上传

1.创建账户

2.在web界面上在项目-->library仓库-->成员-->新建成员 添加开发人员tiger管理, 此时tiger就具备了pull/push权限

3. 在docker主机master中

# docker logout

Removing login credentials for https://index.docker.io/v1/

[root@docker ~]# docker login harbor.io

Username: tiger

Password:

WARNING! Your password will be stored unencrypted in /root/.docker/config.json.

Configure a credential helper to remove this warning. See

https://docs.docker.com/engine/reference/commandline/login/#credentials-store

Login Succeeded

# docker images

REPOSITORY TAG IMAGE ID CREATED SIZE

nginx latest be1f31be9a87 13 days ago 109MB

tomcat latest 41a54fe1f79d 4 weeks ago 463MB

# docker image tag daocloud.io/library/nginx:latest harbor.io/library/nginx

# docker push harbor.io/library/nginx

The push refers to repository [harbor.io/library/nginx]

92b86b4e7957: Pushed

94ad191a291b: Pushed

8b15606a9e3e: Pushed

latest: digest: sha256:204a9a8e65061b10b92ad361dd6f406248404fe60efd5d6a8f2595f18bb37aad size: 948

在web界面中查看镜像是否被上传到仓库中

下载

# docker login harbor.io

Username: admin

Password:

WARNING! Your password will be stored unencrypted in /root/.docker/config.json.

Configure a credential helper to remove this warning. See

https://docs.docker.com/engine/reference/commandline/login/#credentials-store

Login Succeeded

# docker pull harbor.io/library/nginx

Using default tag: latest

latest: Pulling from library/nginx

802b00ed6f79: Pull complete

5291925314b3: Pull complete

bd9f53b2c2de: Pull complete

Digest: sha256:204a9a8e65061b10b92ad361dd6f406248404fe60efd5d6a8f2595f18bb37aad

Status: Downloaded newer image for harbor.io/library/nginx:latest

# docker image ls

REPOSITORY TAG IMAGE ID CREATED SIZE

harbor.io/library/nginx latest be1f31be9a87 13 days ago 109MB

定期清理

存储库删除分为两步:

- 第一步: 在web中删除, 这是标记删除, 存储库中还存在

- 第二步: 确保所有人都没有用仓库的情况下, 执行以下指令, 若有人上传/下载镜像可能会出现错误

# docker-compose stop

# docker run -it --name gc --rm --volumes-from registry vmware/registry:2.6.2-photon garbage-collect /etc/registryconfig.yml

# docker-compose start

--------------------------

node配置

# cat /etc/docker/daemon.json

{

"insecure-registries": ["http://10.3.148.212"]

}

# systemctl daemon-reload

# systemctl restart docker

# docker login http://10.3.148.212

在集群中创建保存授权令牌的 Secret

kubectl create secret docker-registry regcred \

--docker-server=<你的镜像仓库服务器> \

--docker-username=<你的用户名> \

--docker-password=<你的密码> \

--docker-email=<你的邮箱地址>

kubectl create secret docker-registry tiger-registry \

--docker-server=http://10.3.148.212 \

--docker-username=admin \

--docker-password=Harbor12345 \

--docker-email=goudan@tiger.com

在这里:

<your-registry-server> 是你的私有 Docker 仓库全限定域名(FQDN)。 DockerHub 使用 https://index.docker.io/v1/。

<your-name> 是你的 Docker 用户名。

<your-pword> 是你的 Docker 密码。

<your-email> 是你的 Docker 邮箱。

这样你就成功地将集群中的 Docker 凭证设置为名为 regcred 的 Secret。

创建一个使用你的 Secret 的 Pod

apiVersion: v1

kind: Pod

metadata:

name: private-reg

spec:

containers:

- name: private-reg-container

image: 10.3.148.212/library/nginx:1.20

imagePullSecrets:

- name: tiger-registry

集群信息搜集

在master 查看 node状态:

[root@vm1 etc]# kubectl get nodes

NAME STATUS AGE

192.168.245.251 Ready 17h

192.168.245.252 Ready 17h

删除节点:无效且显示的也可以删除

[root@k8s-master ~]# kubectl delete node 192.168.245.252

node "192.168.245.252" deleted

[root@vm1 etc]# kubectl get node 192.168.245.251

NAME STATUS AGE

192.168.245.251 Ready 17h

注:节点IP可以用空格隔开写多个

使用 kubectl describe 命令,查看一个 API 对象的细节:

注意:Events(事件) 值得你特别关注

在 Kubernetes 执行的过程中,对 API 对象的所有重要操作,都会被记录在这个对象的 Events 里,并且显示在 kubectl describe 指令返回的结果中。

比如,对于这个 Pod,我们可以看到它被创建之后,被调度器调度(Successfully assigned)到了 node-1,拉取了指定的镜像(pulling image),然后启动了 Pod 里定义的容器(Started container)。

这个部分正是我们将来进行 Debug 的重要依据。如果有异常发生,一定要第一时间查看这些 Events,往往可以看到非常详细的错误信息。

[root@vm1 etc]# kubectl describe node 192.168.245.251

#注意:最后被查看的节点名称只能用get nodes里面查到的name!

Name: 192.168.245.251

Role:

Labels: beta.kubernetes.io/arch=amd64

beta.kubernetes.io/os=linux

kubernetes.io/hostname=192.168.245.251

Taints: <none>

CreationTimestamp: Tue, 20 Mar 2018 05:25:09 -0400

....

....

查看集群信息:

[root@vm1 etc]# kubectl cluster-info

Kubernetes master is running at http://localhost:8080

查看各组件信息:

未使用安全连接

[root@vm1 etc]# kubectl -s http://localhost:8080 get componentstatuses

NAME STATUS MESSAGE ERROR

controller-manager Healthy ok

etcd-0 Healthy {"health": "true"}

scheduler Healthy ok

使用安全连接:

[root@master /]# kubectl -s https://192.168.1.205:6443 get componentstatuses

NAME STATUS MESSAGE ERROR

controller-manager Healthy ok

scheduler Healthy ok

etcd-0 Healthy {"health": "true"}

查看service的信息:

[root@vm1 etc]# kubectl get service

NAME CLUSTER-IP EXTERNAL-IP PORT(S) AGE

kubernetes 10.254.0.1 <none> 443/TCP 22h

查看所有名称空间内的资源:

# kubectl get pods --all-namespaces

同时查看多种资源信息:

[root@master ~]# kubectl get pod,svc -n kube-system

发布第一个容器化应用

发布第一个容器化应用

扮演一个应用开发者的角色,使用这个 Kubernetes 集群发布第一个容器化应用。

1. 作为一个应用开发者,你首先要做的,是制作容器的镜像。

2. 有了容器镜像之后,需要按照 Kubernetes 项目的规范和要求,将你的镜像组织为它能够"认识"的方式,然后提交上去。

什么才是 Kubernetes 项目能"认识"的方式?

就是使用 Kubernetes 的必备技能:编写配置文件。

这些配置文件可以是 YAML 或者 JSON 格式的。

Kubernetes 跟 Docker 等很多项目最大的不同,就在于它不推荐你使用命令行的方式直接运行容器(虽然 Kubernetes 项目也支持这种方式,比如:kubectl run),而是希望你用 YAML 文件的方式,即:把容器的定义、参数、配置,统统记录在一个 YAML 文件中,然后用这样一句指令把它运行起来:

# kubectl create -f 我的配置文件

# kubectl apply -f 我的配置文件

好处:

你会有一个文件能记录下 Kubernetes 到底"run"了什么。

使用YAML创建Pod

YAML 文件,对应到 k8s 中,就是一个 API Object(API 对象)。当你为这个对象的各个字段填好值并提交给 k8s 之后,k8s 就会负责创建出这些对象所定义的容器或者其他类型的 API 资源。

部署第一个应用

# cat Dockerfile

FROM daocloud.io/library/nginx:1.10

COPY index.html /usr/share/nginx/html

EXPOSE 80

CMD /bin/sh -c 'nginx -g "daemon off;"'

# docker build -t my_nginx:v1 .

把镜像分发到其他工作节点

编写yaml文件内容如下:

---

apiVersion: v1

kind: Pod

metadata:

name: my-nginx

labels:

app: web

spec:

containers:

- name: front-end

image: my_nginx:v1

imagePullPolicy: IfNotPresent

ports:

- containerPort: 80

创建Pod:

# kubectl apply -f nginx-pod.yaml

kubectl get po -o wide

验证语法:

当你不确定声明的配置文件是否书写正确时,使用以下命令要验证:

# kubectl create -f ./hello-world.yaml --validate

注:使用--validate只是会告诉你它发现的问题,仍然会按照配置文件的声明来创建资源,除非有严重的错误使创建过程无法继续,如必要的字段缺失或者字段值不合法,不在规定列表内的字段会被忽略。

查看pod状态

通过get命令来查看被创建的pod。

如果执行完创建pod的命令之后,你的速度足够快,那么使用get命令你将会看到以下的状态:

## kubectl get po

NAME READY STATUS RESTARTS AGE

my-nginx 1/1 Running 0 2d17h

cat nginx-svc.yaml

---

apiVersion: v1

kind: Service

metadata:

name: my-nginx-svc

spec:

type: NodePort

ports:

- port: 88

targetPort: 80

nodePort: 30012

selector:

app: web

kubectl apply -f nginx-svc.yaml

kubectl get svc

kubectl describe svc my-nginx-svc

访问 node—IP:svc-port

---------------

注: Pod创建过程中如果出现错误,可以使用kubectl describe 进行排查。

各字段含义:

NAME: Pod的名称

READY: Pod的准备状况,右边的数字表示Pod包含的容器总数目,左边的数字表示准备就绪的容器数目。

STATUS: Pod的状态。

RESTARTS: Pod的重启次数

AGE: Pod的运行时间。

pod的准备状况指的是Pod是否准备就绪以接收请求,Pod的准备状况取决于容器,即所有容器都准备就绪了,Pod才准备就绪。这时候kubernetes的代理服务才会添加Pod作为分发后端,而一旦Pod的准备状况变为false(至少一个容器的准备状况为false),kubernetes会将Pod从代理服务的分发后端移除,即不会分发请求给该Pod。

一个pod刚被创建的时候是不会被调度的,因为没有任何节点被选择用来运行这个pod。调度的过程发生在创建完成之后,但是这个过程一般很快,所以你通常看不到pod是处于unscheduler状态的除非创建的过程遇到了问题。

pod被调度之后,分配到指定的节点上运行,这时候,如果该节点没有所需要的image,那么将会自动从默认的Docker Hub上pull指定的image,一切就绪之后,看到pod是处于running状态了:

# kubectl get pods

NAME READY STATUS RESTARTS AGE

my-nginx-379829228-2zjv3 1/1 Running 0 1h

my-nginx-379829228-mm8f8 1/1 Running 0 1h

查看pods所在的运行节点:

# kubectl get pods -o wide

查看pods定义的详细信息:

# kubectl get pods -o yaml

# kubectl get pod nginx-8v3cg --output yaml

kubectl get支持以Go Template方式过滤指定的信息,比如查询Pod的运行状态

# kubectl get pods busybox --output=go-template --template={{.status.phase}}

Running

查看pod输出:

你可能会有想了解在pod中执行命令的输出是什么,和Docker logs命令一样,kubectl logs将会显示这些输出:

# kubectl logs pod名称

hello world

查看kubectl describe 支持查询Pod的状态和生命周期事件:

[root@k8s-master ~]# kubectl describe pod busybox

Name: busybox

Namespace: default

Node: k8s-node-1/116.196.105.133

Start Time: Thu, 22 Mar 2018 09:51:35 +0800

Labels: name=busybox

role=master

Status: Pending

IP:

Controllers: <none>

Containers:

busybox:

Container ID:

Image: docker.io/busybox

Image ID:

Port:

Command:

sleep

360000

State: Waiting

Reason: ContainerCreating

Ready: False

Restart Count: 0

Volume Mounts: <none>

Environment Variables: <none>

Conditions:

Type Status

Initialized True

Ready False

PodScheduled True

No volumes.

QoS Class: BestEffort

Tolerations: <none>

Events:

FirstSeen LastSeen Count From SubObjectPath Type Reason Message

--------- -------- ----- ---- ------------- -------- ------ -------

7m 7m 1 {default-scheduler } Normal Scheduled Successfully assigne

d busybox to k8s-node-1 7m 1m 6 {kubelet k8s-node-1} Warning FailedSync Error syncing pod, s

kipping: failed to "StartContainer" for "POD" with ErrImagePull: "image pull failed for registry.access.redhat.com/rhel7/pod-infrastructure:latest, this may be because there are no credentials on this request. details: (open /etc/docker/certs.d/registry.access.redhat.com/redhat-ca.crt: no such file or directory)"

6m 13s 27 {kubelet k8s-node-1} Warning FailedSync Error syncing pod, skipping: failed to "StartContain

er" for "POD" with ImagePullBackOff: "Back-off pulling image \"registry.access.redhat.com/rhel7/pod-infrastructure:latest\""

各字段含义:

Name: Pod的名称

Namespace: Pod的Namespace。

Image(s): Pod使用的镜像

Node: Pod所在的Node。

Start Time: Pod的起始时间

Labels: Pod的Label。

Status: Pod的状态。

Reason: Pod处于当前状态的原因。

Message: Pod处于当前状态的信息。

IP: Pod的PodIP

Replication Controllers: Pod对应的Replication Controller。

Containers:Pod中容器的信息

Container ID: 容器的ID

Image: 容器的镜像

Image ID:镜像的ID

State: 容器的状态

Ready: 容器的准备状况(true表示准备就绪)。

Restart Count: 容器的重启次数统计

Environment Variables: 容器的环境变量

Conditions: Pod的条件,包含Pod准备状况(true表示准备就绪)

Volumes: Pod的数据卷

Events: 与Pod相关的事件列表

进入Pod对应的容器内部

[root@k8s-master /]# kubectl exec -it myweb-76h6w /bin/bash

删除pod:

# kubectl delete pod pod名1 pod名2 //单个或多个删除

# kubectl delete pod --all //批量删除

例:

[root@k8s-master /]# kubectl delete pod hello-world

pod "hello-world" deleted

重新启动基于yaml文件的应用

# kubectl delete -f XXX.yaml

# kubectl apply -f XXX.yaml

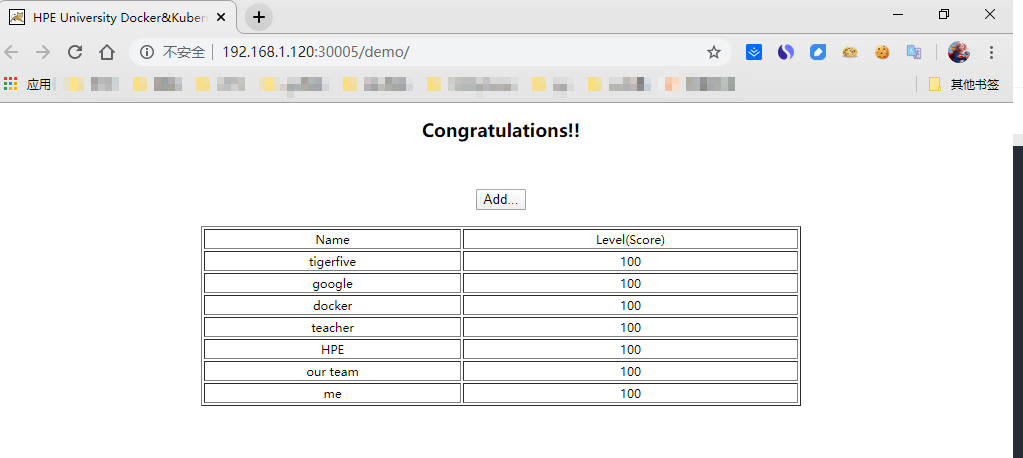

部署第一个小Demo

基础环境

系统版本:CentOS Linux release 7.6

kubernetes版本:kubernetes1.14.0

Docker版本: Docker CE 19.03.5

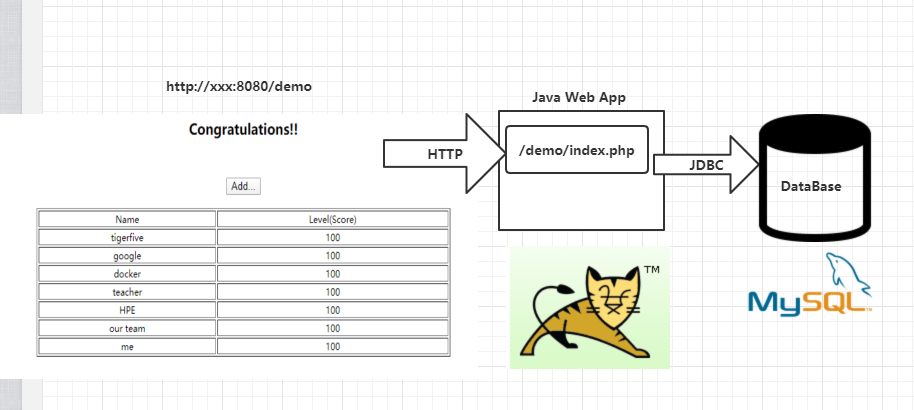

此 Java web项目相对比较简单, 是一个运行在Tomcat里的 Web App, 如下图所示, JSP页面通过 JDBC 直接访问 MySQL 数据库并展示数据。只要正确连接到了数据库,就会自动完成对应的 Table 表的创建与初始化数据的准备工作

启动mysql服务

首先为 MySql 服务创建一个 RC 定义文件 mysql-rc.yaml

apiVersion: v1

kind: ReplicationController

metadata:

name: mysql

spec:

replicas: 1

selector:

app: mysql

template:

metadata:

labels:

app: mysql

spec:

containers:

- name: mysql

image: daocloud.io/library/mysql:5.7

ports:

- containerPort: 3306

env:

- name: MYSQL_ROOT_PASSWORD

value: "123456"

创建好 mysql-rc.yaml 文件后,将他发布到 Kubernetes 集群后,我们在 Master 上执行下列命令:

# kubectl apply -f mysql-rc.yaml

replicationcontroller "mysql" created

查看创建的 RC:

# kubectl get rc

NAME DESIRED CURRENT READY AGE

mysql 1 1 1 103m

查看Pod创建情况

# kubectl get pod

NAME READY STATUS RESTARTS AGE

mysql-lxt5v 1/1 Running 0 104m

创建 Kubernetes Service - MySql 定义文件 (mysql-svc.yaml)

apiVersion: v1

kind: Service

metadata:

name: mysql

spec:

ports:

- port: 3306

selector:

app: mysql

运行 kubectl 命令,创建 Service

kubectl apply -f mysql-svc.yaml

serevice "mysql" created

查看刚刚创建的service

kubectl get svc

NAME TYPE CLUSTER-IP EXTERNAL-IP PORT(S) AGE

mysql ClusterIP 10.1.216.201 <none> 3306/TCP 3h50m

可以看到,MySql 服务分配了一个值为 10.1.216.201 的 Cluster IP的地址。

启动Tomcat应用

# cat myweb-rc.yaml

apiVersion: v1

kind: ReplicationController

metadata:

name: myweb

spec:

replicas: 2

selector:

app: myweb

template:

metadata:

labels:

app: myweb

spec:

containers:

- name: myweb

image: kubeguide/tomcat-app:v1

ports:

- containerPort: 8080

env:

- name: MYSQL_SERVICE_HOST

value: 10.1.216.201

------------

svc-name.namespace.svc.cluster.local

mysql.default.svc.cluster.local

注意: 创建的 myweb-rc.yaml 应注意 MYSQL_SERVICE_HOST 的配置。

# kubectl apply -f myweb-rc.yaml

replicationcontroller "myweb" created

# kubectl get pods

NAME READY STATUS RESTARTS AGE

mysql-lxt5v 1/1 Running 0 111m

myweb-hs6nw 1/1 Running 0 3h51m

创建对应的 Service

# cat myweb-svc.yaml

apiVersion: v1

kind: Service

metadata:

name: myweb

spec:

type: NodePort

ports:

- port: 8080

nodePort: 30005

selector:

app: myweb

# kubectl apply -f myweb-svc.yaml

servcice "myweb" created

# kubectl get svc

NAME TYPE CLUSTER-IP EXTERNAL-IP PORT(S) AGE

mysql ClusterIP 10.1.216.201 <none> 3306/TCP 3h55m

myweb NodePort 10.1.153.70 <none> 8080:30005/TCP 3h53m

.png)

点击Add 添加提交记录

.png)

完成

yaml配置文件详解

除了某些强制性的命令,如:kubectl run或者expose等,会隐式创建rc或者svc,k8s还允许通过配置文件的方式来创建这些操作对象。

通常,使用配置文件的方式会比直接使用命令行更可取,因为这些文件可以进行版本控制,而且文件的变化和内容也可以进行审核,当使用及其复杂的配置来提供一个稳健、可靠和易维护的系统时,这些点就显得非常重要。

在声明定义配置文件的时候,所有的配置文件都存储在YAML或者JSON格式的文件中并且遵循k8s的资源配置方式。

kubectl可以创建、更新、删除和获得API操作对象,当前apiVersion、kind和name会组成一个API Path以供kubectl来调用。

YAML是专门用来写配置文件的语言,非常简洁和强大,使用比json更方便。它实质上是一种通用的数据串行化格式。

kubernetes中用来定义YAML文件创建Pod和创建Deployment等资源。

使用YAML用于K8s的定义的好处:

便捷性: 不必添加大量的参数到命令行中执行命令

可维护性:YAML文件可以通过源头控制,跟踪每次操作

灵活性: YAML可以创建比命令行更加复杂的结构

YAML语法规则:

1. 大小写敏感

2. 使用缩进表示层级关系

3. 缩进时不允许使用Tab键,只允许使用空格

4. 缩进的空格数不重要,只要相同层级的元素左侧对齐即可

5. "表示注释,从这个字符一直到行尾,都会被解析器忽略

注:在同一个yaml配置文家内可以同时定义多个资源

在 k8s 中,只需要知道两种结构类型:

1.Lists

2.Maps

YAML Maps

Map指的是字典,即一个Key:Value 的键值对信息。

例如:

---

apiVersion: v1

kind: Pod

注:--- 为可选的分隔符 ,当需要在一个文件中定义多个结构的时候需要使用。上述内容表示有两个键apiVersion和kind,分别对应的值为v1和Pod。

Maps的value既能够对应字符串也能够对应一个Maps。

例如:

---

apiVersion: v1

kind: Pod

metadata:

name: kube100-site

labels:

app: web

注:上述的YAML文件中,metadata这个KEY对应的值为一个Maps,而嵌套的labels这个KEY的值又是一个Map。实际使用中可视情况进行多层嵌套。

YAML处理器根据行缩进来知道内容之间的关联。上述例子中,使用两个空格作为缩进,但空格的数据量并不重要,只是至少要求一个空格并且所有缩进保持一致的空格数 。例如,name和labels是相同缩进级别,因此YAML处理器知道他们属于同一map;它知道app是lables的值因为app的缩进更大。

注意:在YAML文件中绝对不要使用tab键

YAML Lists

List即列表,就是数组

例如:

args:

- beijing

- shanghai

- shenzhen

- guangzhou

可以指定任何数量的项在列表中,每个项的定义以连字符(-)开头,并且与父元素之间存在缩进。

在JSON格式中,表示如下:

{

"args": ["beijing", "shanghai", "shenzhen", "guangzhou"]

}

当然Lists的子项也可以是Maps,Maps的子项也可以是List,例如:

---

apiVersion: v1

kind: Pod

metadata:

name: kube100-site

labels:

app: web

spec:

containers:

- name: front-end

image: nginx

ports:

- containerPort: 80

- name: flaskapp-demo

image: jcdemo/flaskapp

ports: 8080

如上述文件所示,定义一个containers的List对象,每个子项都由name、image、ports组成,每个ports都有一个KEY为containerPort的Map组成,转成JSON格式文件:

{

"apiVersion": "v1",

"kind": "Pod",

"metadata": {

"name": "kube100-site",

"labels": {

"app": "web"

},

},

"spec": {

"containers": [{

"name": "front-end",

"image": "nginx",

"ports": [{

"containerPort": "80"

}]

}, {

"name": "flaskapp-demo",

"image": "jcdemo/flaskapp",

"ports": [{

"containerPort": "5000"

}]

}]

}

}

k8s的pod中运行容器,一个包含简单的Hello World容器的pod可以通过YAML文件这样来定义:

apiVersion: v1

kind: Pod deployment service

metadata:

name: hello-world

spec: # 当前pod内容的声明

restartPolicy: Never

containers:

- name: hello

image: "ubuntu:14.04"

command: ["/bin/echo","hello","world"]

创建的pod名为metadata.name的值:hello-world,该名称必须是唯一的。

spec的内容为该pod中,各个容器的声明:

restartPolicy:Never表示启动后运行一次就终止这个pod。

containers[0].name为容器的名字。

containers[0].image为该启动该容器的镜像。

containers[0].command相当于Dockerfile中定义的Entrypoint,可以通过下面的方式来声明cmd的参数:

command: ["/bin/echo"]

args: ["hello","world"]

玩转Pod

Pod API属性详解

Pod API 对象

Pod是 k8s 项目中的最小编排单位。将这个设计落实到 API 对象上,容器(Container)就成了 Pod 属性里一个普通的字段。

问题:

到底哪些属性属于 Pod 对象,哪些属性属于 Container?

解决:

Pod 扮演的是传统环境里"虚拟机"的角色。是为了使用户从传统环境(虚拟机环境)向 k8s(容器环境)的迁移,更加平滑。

把 Pod 看成传统环境里的"机器"、把容器看作是运行在这个"机器"里的"用户程序",那么很多关于 Pod 对象的设计就非常容易理解了。

凡是调度、网络、存储,以及安全相关的属性,基本上是 Pod 级别的。

共同特征是,它们描述的是"机器"这个整体,而不是里面运行的"程序"。

比如:

配置这个"机器"的网卡(即:Pod 的网络定义)

配置这个"机器"的磁盘(即:Pod 的存储定义)

配置这个"机器"的防火墙(即:Pod 的安全定义)

这台"机器"运行在哪个服务器之上(即:Pod 的调度)

kind:

指定了这个 API 对象的类型(Type),是一个 Pod,根据实际情况,此处资源类型可以是Deployment、Job、Ingress、Service等。

metadata:

包含Pod的一些meta信息,比如名称、namespace、标签等信息。

spec:

specification of the resource content 指定该资源的内容,包括一些container,storage,volume以及其他Kubernetes需要的参数,以及诸如是否在容器失败时重新启动容器的属性。可在特定Kubernetes API找到完整的Kubernetes Pod的属性。

容器可选的设置属性:

除了上述的基本属性外,还能够指定复杂的属性,包括容器启动运行的命令、使用的参数、工作目录以及每次实例化是否拉取新的副本。 还可以指定更深入的信息,例如容器的退出日志的位置。

容器可选的设置属性包括:

name、image、command、args、workingDir、ports、env、resource、volumeMounts、livenessProbe、readinessProbe、livecycle、terminationMessagePath、imagePullPolicy、securityContext、stdin、stdinOnce、tty

跟"机器"相关的配置

nodeSelector:

是一个供用户将 Pod 与 Node 进行绑定的字段,用法:

apiVersion: v1

kind: Pod

...

spec:

nodeSelector:

disktype: ssd

表示这个 Pod 永远只能运行在携带了"disktype: ssd"标签(Label)的节点上;否则,它将调度失败。

NodeName:

一旦 Pod 的这个字段被赋值,k8s就会被认为这个 Pod 已经经过了调度,调度的结果就是赋值的节点名字。

这个字段一般由调度器负责设置,用户也可以设置它来"骗过"调度器,这个做法一般是在测试或者调试的时候才会用到。

HostAliases:

定义 Pod 的 hosts 文件(比如 /etc/hosts)里的内容,用法:

apiVersion: v1

kind: Pod

...

spec:

hostAliases:

- ip: "10.1.2.3"

hostnames:

- "foo.remote"

- "bar.remote"

...

这里设置了一组 IP 和 hostname 的数据。

此Pod 启动后,/etc/hosts 的内容将如下所示:

# cat /etc/hosts

# Kubernetes-managed hosts file.

127.0.0.1 localhost

...

10.244.135.10 hostaliases-pod

10.1.2.3 foo.remote

10.1.2.3 bar.remote

注意:在 k8s 中,如果要设置 hosts 文件里的内容,一定要通过这种方法。否则,如果直接修改了 hosts 文件,在 Pod 被删除重建之后,kubelet 会自动覆盖掉被修改的内容。

凡是跟容器的 Linux Namespace 相关的属性,也一定是 Pod 级别的

原因:Pod 的设计,就是要让它里面的容器尽可能多地共享 Linux Namespace,仅保留必要的隔离和限制能力。这样,Pod 模拟出的效果,就跟虚拟机里程序间的关系非常类似了。

举例,一个 Pod 定义 yaml 文件如下:

apiVersion: v1

kind: Pod

metadata:

name: nginx

spec:

shareProcessNamespace: true

containers:

- name: nginx

image: nginx

- name: shell

image: busybox

stdin: true

tty: true

1. 定义了 shareProcessNamespace=true

表示这个 Pod 里的容器要共享 PID Namespace

2. 定义了两个容器:

一个 nginx 容器

一个开启了 tty 和 stdin 的 shell 容器

在 Pod 的 YAML 文件里声明开启它们俩,等同于设置了 docker run 里的 -it(-i 即 stdin,-t 即 tty)参数。

可以直接认为 tty 就是 Linux 给用户提供的一个常驻小程序,用于接收用户的标准输入,返回操作系统的标准输出。为了能够在 tty 中输入信息,需要同时开启 stdin(标准输入流)。

此 Pod 被创建后,就可以使用 shell 容器的 tty 跟这个容器进行交互了。

创建资源并连接到 shell 容器的 tty 上:

# kubectl attach -it nginx -c shell

在 shell 容器里执行 ps 指令,查看所有正在运行的进程:

# kubectl attach -it nginx -c shell

/ # ps ax

PID USER TIME COMMAND

1 root 0:00 /pause